Archives pour Référents

Depuis à peine quelques semaines, mes gentils clients Ethné et Philippe De Vienne, ont mis en ligne pour le marché américain, le site Spicetrekkers.com (d’ailleurs je vous parlais récemment de cet imbécile qui voulait leur faire du tort parce que le site est anglophone). Hier nous avions une réunion pour que je continue de prodiguer mes conseils de gestion Web et c’est là que Philippe m’a révélé l’efficacité du référencement de son site, qui n’en est qu’à ses premiers balbutiements.

Il me dit être particulièrement content d’avoir reçu une commande de l’un des plus prestigieux restaurants américains pour 5 kilos du piment chilhuacle negro. Une commande de cette importance ne passa pas inaperçue et Philippe s’empressa de demander au client comment il était arrivé à son site. C’est là qu’il apprit que Tom Guilliland, l’un des proprios de la ” Funda San Miguel ” à Austin Texas, est un passionné de cuisine mexicaine et que depuis des mois, sporadiquement il cherche sur Google, du piment chihuacle sans jamais être capable d’en trouver. Mais comme par magie (et c’est justement ça la magie du SEO et d’une structure d’URL efficace), ce jour là il trouva la page de SpiceTrekkers et s’empressa d’en commander 5 kilos (sans doute de peur que l’approvisionnement disparaisse) et de découvrir les autres spécialités de piments de mon client que sont les piments pasilla de oaxaca, les piments chilhuacle negro, chilhuacle rojo ou chilhuacle amarillo (je vous avoue ici que je n’ai vraiment aucune idée de ce que font de particulier ces piments forts).

Philippe était vraiment enthousiaste de découvrir ces ventes pour un produit très haut de gamme alors qu’il avait plutôt la certitude que ce serait les produits bas de gamme qui attireraient les faveurs des consommateurs en premier. Mais ça fait déjà longtemps que je sais et que je dis que le Web est un médium extraordinaire pour les produits et services de niche et que justement, les produits de consommation courante sont ceux qui auront le plus de difficulté à se tailler une place dans l’encombrement des résultats de recherches.

Tout ça pour vous dire que ce site ne fait que commencer sa vie et que déjà, les résultats sont plus que probants. C’est d’ailleurs avec une certaine tristesse que je réalise ne pas être payée aux résultats avec ce client = grrr. Mais d’un autre côté, c’est ça mon modèle d’affaires et je sais que des clients satisfaits et prospères sont les meilleurs arguments de croissance de mon chiffre d’affaires ☺

MAJ

D’ailleurs au moment d’écrire ces lignes, un usager du célèbre forum foodies Chow vient de leur faire justement une belle promo pour leur épice Ras el Hanout. Et dire que le site ne vient d’être en ligne que depuis une quinzaine de jours ☺

Article publié le vendredi, 25 janvier 2013 sous les rubriques Commerce de détail en ligne, Moteurs de recherche et référencement de sites Web, Référents et Stratégies de commerce électronique.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

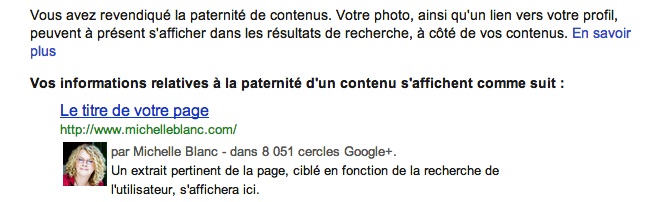

Il y a plusieurs mois de ça, j’ai suivi la procédure de Google pour m’inscrire à leur service Google Authorship. C’est donc avec surprise et satisfaction que cette nuit je reçus un courriel de Google Authorship m’informant que je faisais finalement partie de ce système.

Bénéfices de Google Authorship

Il y a plusieurs avantages pour un auteur à être reconnu comme tel par Google. Tout d’abord, les résultats de recherches qui pointeront vers vos contenus auront désormais une photo de vous accompagnant dans les résultats. Ce détail peut certainement augmenter l’achalandage, créer ou améliorer votre « branding » et solidifier plus encore votre lien avec vos lecteurs.

Search Engine Land présente l’avantage qu’une fois que votre statut d’auteur sera confirmé par Google, si un lecteur clique sur un hyperlien menant vers l’un de vos contenus et clique sur le bouton retour par la suite, Google lui présentera trois nouveaux résultats provenant de la masse de vos contenus.

D’ailleurs, lorsque vous êtes un auteur reconnu par Google, vous disposez d’un outil supplémentaire dans Google Webmaster Tool pour suivre l’évolution des impressions de vos contenus dans les résultats de recherches. Mais la cerise sur le sunday et que désormais, les contenus que vous mettrez en ligne seront attachés à votre présence web et que les différents copieurs de ceux-ci (ce que l’on nomme aussi le web scraping) seront encore plus fortement identifiés et pénalisé par l’engin de recherche qui n’aime définitivement pas les contenus dupliqués.

Mais l’un des avantages futurs que présente Webpronews est qu’éventuellement, l’algorithme de Google risque de fortement valorisé les contenus d’auteurs confirmés que ceux d’auteurs inconnus. Ce sera alors encore un autre discriminant positif pour ceux qui se donnent la peine de créer des contenus originaux.

Dans tous les cas, comme il faut avoir un profil Google + pour profiter du statut d’auteur reconnu par Google, ça permet encore une fois de militer pour une présence dans Google + qui devient dès lors, un outil de référencement à ne pas négliger.

Pour vérifier le contenu des pages “Michelle Blanc” qui sont répertoriées par Google Authorship

https://www.google.com/search?q=Michelle%20Blanc&tbs=ppl_ids:–115479588070194295299-,ppl_aut:1

Article publié le mercredi, 24 octobre 2012 sous les rubriques Google +, Google Plus, Moteurs de recherche et référencement de sites Web, Référents, statistiques des affaires électroniques et Stratégie d'affaires.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Ce matin j’ai partagé le statut suivant :

Toujours navrant de constater à quel point les médias trad. ne font que du “push” sur les médias sociaux

J’ai pris l’exemple des comptes Twitter des grands groupes de presse au Québec, mais j’aurai pu aussi bien prendre celui des médias électroniques, que ceux de plusieurs journalistes.

https://twitter.com/#!/Jdemontreal

https://twitter.com/#!/LeDevoir

https://twitter.com/#!/LP_LaPresse

https://twitter.com/#!/mtlgazette

https://twitter.com/#!/la_lesaffaires

On peut y remarquer que les statuts de ces divers médias ne traitent presque exclusiment d’eux-mêmes. Ces médias ne font pas de RT (si ce n’est que de l’info de l’un de leurs propres journalistes ou pour une caution à leur endroit d’un membre de la plèbe), ils ne dialoguent avec personne et n’ont, somme toute, aucune interaction avec l’auditoire. ALLÔ LA COMMUNICATION ???

Ils sont les meilleurs et ils le montrent ! Ça me fait aussi songer à un article vu sur Gigaom cette semaine Is linking just polite, or is it a core value of journalism? C’est le même genre de constat. Les journalistes ne citent pas leurs sources (par hyperlien sur le Web ou en mentionnant un autre média) lorsqu’ils « dévoilent » la nouvelle. Ils ont rêvé à ça durant la nuit et au réveil, ils savaient par exemple que Apple a acheté une nouvelle entreprise !

Late last week, TechCrunch writer MG Siegler broke the news that Apple was buying an app-discovery service called Chomp — although he didn’t say where that news came from, just that it was a reliable source. The Wall Street Journalreported the same news several hours later, confirmed by an Apple source, but didn’t link to Siegler, who then wrote aprofanity-laced tirade criticizing the WSJ for its failure to include a link to him in its story (we at GigaOM, meanwhile, wrote about why the acquisition made sense for Apple, and credited TechCrunch with breaking the story).

Je connais une couple de journalistes technos qui dans leur blogue ou leur papier, ne disent jamais « j’ai lu ça dans tel article, blogue, forum » et j’ajoute MA perspective. Non, ça ne ferait sans doute pas sérieux et la science infuse fait sans doute partie du fameux code déontologique des journalistes. Quoi qu’il en soit, en cette ère de changement, ceux qui apprendront le plus vite à communiquer dans les deux sens et à reconnaître le crédit de la nouvelle par hyperlien, à qui de droit, sont ceux qui risquent le plus de devenir eux-mêmes des sources crédibles…

I’ve argued before that I think this failure to link is a crucial mistake that mainstream media outlets make, and also an issue of trust: since the Journal must know that at least some people saw the Siegler post, why not link to it? The only possible reason — apart from simply forgetting to do so — is that the paper would rather try to pretend that it was the first to know this information (and it also apparently has a policy of not linking if a WSJ reporter can independently confirm the news).

Is that the right way to operate online? I would argue that it is not, especially in an environment where trust matters more than so-called “scoops.” I think that is the kind of world we are operating in now, since the half-life of the scoop is so short. But if scoops don’t matter, then why should it matter if the WSJ credits Siegler or not? I think that failure to link decreases the trust readers have, because it suggests (or tries to imply) that the outlet in question came by the information independently when they did not.

Article publié le mardi, 28 février 2012 sous les rubriques Marketing 2.0, Médias sociaux, Medias et Internet, Référents, Relations publiques Internet, Stratégie d'affaires et Twitter ou le microblogging.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Journal de Montréal, La Presse, Le Devoir, Les Affaires, The Gazette.

Aujourd’hui était une journée régulière (c’est-à-dire une journée lors de laquelle je n’ai pas été médiatisée outre mesure). Je me suis donc mise à calculer l’apport de Twitter et de Facebook à mon trafic. J’ai été étonnée de découvrir que Twitter draine 12.5% et Facebook 6.3% de mon trafic direct (lire ici que cela ne tient pas compte de mes lecteurs via les fils RSS ou des lecteurs de Feedblitz par exemple) calculé à partir de mon interface Mybloglog. Il va de soi que je ne fais pas que de l’autopromo sur Twitter et Facebook et que si tel était le cas, ces stats seraient probablement en chute libre parce que personne n’aime se faire pousser des contenus d’autopromo. Mais des contenus autopromo qui sont dilués via une foule d’autres contenus, tel que j’en parlais dans un récent billet, ça semble être une source de trafic non négligeable. Dans mon cas particulier, il faut dire que Twitter est assez ciblé pour mon genre de lectorat. Je vais donc continuer d’observer ça et vous arriver un de ces jours avec données plus substantielles…

Article publié le jeudi, 12 mars 2009 sous les rubriques Blogue, Blogues d'affaires, Facebook, Marketing 2.0, Marketing Internet, Médias sociaux, Medias et Internet, Moteurs de recherche et référencement de sites Web, Référents, Twitter ou le microblogging et Web 2.0.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

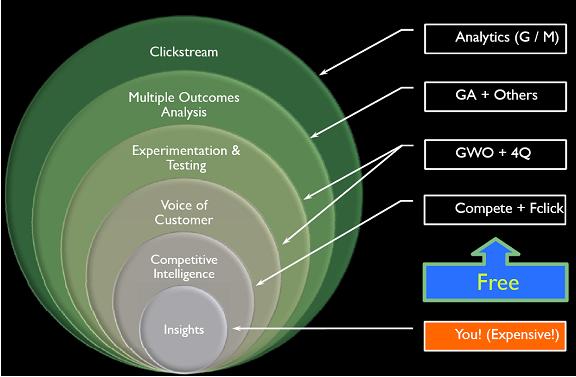

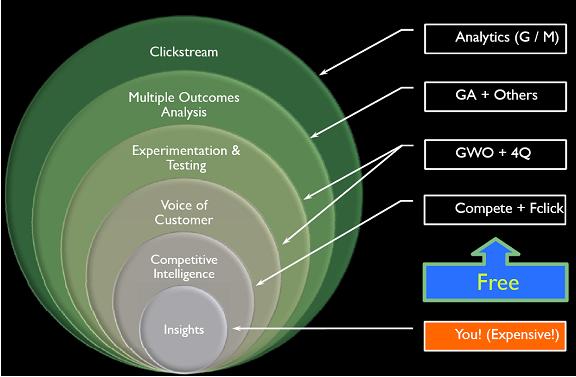

La semaine dernière, c’était la journée sur le 360 Web analytics d’InfoPresse. La journée était spécifique à la réalité de l’utilisation des outils statistiques d’analyse d’une présence web efficace. Les conférenciers locaux ont bien situé l’utilisation de ces outils dans le contexte d’affaires, mais c’est sans contredit l’évangéliste Google Avinash Kaushik que personnellement j’attendais. J’ai eu l’occasion de revoir bien des têtes connues et de serrer la mais au sympathique Stéphane Hamel. Je dois cependant avouer qu’une vieille routière comme moi est restée un peu sur sa faim. C’est bien de situer l’utilisation des outils stats dans un contexte d’affaires et de savoir comment vendre cette idée à son patron, mais quoi encore. Il n’y avait pas vraiment de trucs de pros, de révélations innovantes, de « how to » spécifique. Mais c’est peut-être la formule qui est faite ainsi ? Pourtant, monsieur Jacques Warren a demandé en début de session combien de gens avaient et se servaient de stats sur une base régulière et presque toutes les mains se sont levés. Où était donc le steak ?

Un gentil résumé des présentations a été fait par mes anciens associés d’Adviso Conseil ici, ici, et ici.

Le « steak » c’était peut-être une diapo spécifique d’ Avinash Kaushik qui présentait différents outils statistiques gratuits qui peuvent permettre aux entreprises de monitorer différents aspects d’un processus continu d’analyse statistique Web.

Puis cette autre diapo qui dévoile les outils que M. Kaushik préconise pour chacune des étapes statistiques.

Clickstream : Omniture, Google Analytics, Unica, Webtrends, Indextools, ClickTracks, CoreMe5trics, Gatineau

Multiple outcomes: iperceptions, ForeSee

Experimentation & Testing : Offermatica, Google website optimizer, Optimost

Voice oc Customer: iPerceptions, ForeSee, Ethnio,

Competitive intelligence: HitWise, Compete, Technorati

Foundational tools: Coradiant, Maxamine

Article publié le mardi, 22 avril 2008 sous les rubriques Commerce de détail en ligne, Marketing 2.0, Moteurs de recherche et référencement de sites Web, Outils et références, Référents, statistiques des affaires électroniques et Tourisme en ligne.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Avinash Kaushik, Google Plus, InfoPresse, Jacques Warren, Outils statistiques Web, Stéphane Hamel.