Archives pour Moteurs de recherche et référencement de sites Web

Pourquoi il ne faut pas s’enfarger dans le taux d’engagement : Guide pratique pour les gestionnaires

Ce matin, en discutant avec un client paragouvernemental, j’ai eu l’idée d’écrire ce billet sur le taux d’engagement et les différentes façons de le mesurer. Je leur avais recommandé l’excellent article de Hootsuite, Toutes les façons de calculer le taux d’engagement, et suggéré d’utiliser la quatrième méthode présentée : le Taux d’engagement quotidien (TE quotidien), particulièrement utile pour une analyse à long terme.

Il est important de ne pas chercher à augmenter ce taux à tout prix. Comme je le dis souvent, il est plus efficace de cibler les personnes réellement intéressées par notre sujet plutôt que de vouloir parler à tout le monde. Certains sujets, comme la promotion de nos états financiers annuels, peuvent sembler peu attrayants mais restent essentiels à partager. Par comparaison, une entreprise parlant de hockey aura naturellement plus de facilité à créer un grand taux d’engagement qu’une organisation traitant de génie civil. Il est donc inutile de se comparer à des entités dont les contenus diffèrent grandement des nôtres.

De plus, les calculs de taux d’engagement comportent de nombreuses zones d’ombre. En demandant à Claude.ai si les statistiques de Facebook sont fiables, on peut obtenir un résumé des problèmes.

Fiabilité des statistiques de Facebook :

-

En 2017, le Video Advertising Bureau a révélé que Facebook gonflait ses chiffres de visionnages vidéo en comptant les vues après seulement 3 secondes.

-

En 2021, Facebook a réglé une poursuite en payant 115 millions de dollars, accusé de gonfler les chiffres d’impressions publicitaires.

-

Des articles de The Wall Street Journal (2018 et 2019) et des rapports d’anciens employés de Facebook ont mis en doute la précision des mesures d’impressions.

Bien que Facebook ait reconnu et corrigé certains problèmes, l’opacité demeure. Cependant, les biais constants permettent de comparer nos résultats d’une période à l’autre.

Je recommande également à mes clients de distinguer les contenus peu propices à l’engagement de ceux qui le sont, et de les publier en alternance. Ainsi, les contenus moins engageants seront plus vus grâce aux algorithmes qui mesurent ces taux pour décider de la visibilité des futurs contenus.

(Ce billet a été écrit par un humain mais il a été optimisé par l’application d’IA Marketing de ChatGPT)

Autres lectures d’intérêts:

Facebook’s massive fake numbers problem

Facebook has deleted four planets’ worth of fake users – while real people struggle to get support

Facebook knew ad metrics were inflated, but ignored the problem to make more money, lawsuit claims

Article publié le mercredi, 19 juin 2024 sous les rubriques IA, intelligence Artificielle, Marketing 2.0, Marketing de contenu et Moteurs de recherche et référencement de sites Web.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Depuis plusieurs années, la croissance des GAFAMs se fait beaucoup par acquisition. Il en est de même pour Google. Lorsqu’on remarque une nouvelle fonctionnalité, un nouveau service ou un nouveau média social qui semble lever et déranger le statu quo, on l’acquiert et on l’intègre à son écosystème. C’est ce que Google avait fait entre autres avec Urchin qui devient Google Analytics ou Where 2 Technologies qui devient Google Map. Si cela n’est pas possible, on le copie et on tente de le compétitionner. C’est ce qu’avait fait Google avec Facebook et Twitter il y a quelques années et créant les maintenant défunts Google Wave et Google Plus. Il en est de même pour Facebook qui a acquis Instagram, et plus récemment avec Microsoft qui a investi massivement en « développant un partenariat » avec OpenAI (qui détient Chat GPT).

Comme je le disais dans mon billet La nouvelle frénésie des GAFAM qui se cherchent, la frénésie actuelle est celle de l’intelligence artificielle générative. À ce chapitre Google est déjà très avancé avec son IA Google DeepMind et son application AlphaFold qui a déjà modélisé 200 millions des protéines connues de l’homme en moins d’un an. Elle a aussi eu d’énormes succès avec AlphaGo, son programme d’intelligence capable de jouer eu jeu Go, le jeu le plus ancien du monde et qui est plus complexe que les échecs.

Par contre on ne peut pas dire qu’elle bat des records avec son Google Gemini. Il est donc très surprenant qu’elle décide, pratiquement sur un coup de tête, d’inclure son mal aimé Gemini dans sa vache à lait qu’est le moteur de recherche. En effet, Google utilisera l’IA Gemini pour faire un résumé des réponses aux questions des internautes, reléguant les résultats naturels et payants, qui existent depuis 20 ans, sous un résumé intitulé « AI Overview ». On peut en voir un exemple dans l’article de The Verge que je reproduis ici (et qui ne semble pas encore disponible au Canada).

Source: TheVerge

Il faut comprendre que Google a le souffle dans le dos venant de Bing (qui a intégré Chat GPT) , de Perplexity qui est le premier moteur de recherche à avoir utilisé l’IA et du fait que de très nombreux jeunes utilisent désormais TikTok ou YouTube, comme moteur de recherche. Google n’a donc pas le choix de se réinventer.

Mais ça sent la panique!

On va rappeler que Google a dû fermer la portion de génération d’images de Gemini pour cause de wokisme trop évident. Alors qu’on demandait à Gémini de nous faire des soldats nazis en 1942, ils étaient afrodescendants ou asiatiques. Ce qui de toute évidence est loin de la réalité. Ceux qui ont eu la chance de tester le « AI Overview » ont eu le même genre de déception. En effet, Google suggère de mettre de la colle et des roches dans les ingrédients de la pizza. Disons que ça n’aide en rien Google à donner confiance aux internautes d’utiliser son IA. En outre, Entretemps, je vous invite à lire en complément, l’article **Google vs. Perplexity AI: A Product Manager’s Perspective**.

Article publié le jeudi, 13 juin 2024 sous les rubriques ChatGPT, Google +, Google Plus, Innovation, intelligence Artificielle, LLM, Marketing et IA, Marketing Internet, Moteurs de recherche et référencement de sites Web, Stratégie d'affaires, stratégie web et Technologies Internet.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : AlphaFold, AlphaGo, Bing, ChatGPT, Gémini, Perplexity.

Cette semaine j’ai eu une discussion avec les podcasteurs Français Les éclaireurs du numériques (le podcast sera bientôt disponible). J’y parlais des déboires de Gemini de même que de mon expérience au Social Media Marketing World 2024 et des changements que l’IA apportera à notre domaine du marketing numérique. Entre autres, je donnais l’exemple d’un assistant IA génératif qui est présentement capable de planifier tout un voyage pour l’usager et qui très bientôt fera aussi les réservations pour celui-ci.

À titre d’hébergeur, de restaurateur ou de prestataire touristique, la présence web se devra d’être optimisée pour ce genre de requête. Les techniques de référencement habituelles devront donc s’ajuster pour satisfaire aux besoins de ces nouveaux robots, afin d’apparaître dans les suggestions évoquées. Cette réalité est certainement vraie pour l’industrie du tourisme, mais elle l’est aussi pour tout type d’entreprise qui devra elle aussi s’adapter aux nouvelles réalités qui sont maintenant générées par l’intelligence artificielle. C’est en gros ce que l’on nomme GEO pour Generative Engine optimization ou Optimisation pour l’IA Générative.

Voici donc un exemple éloquent de cette réalité.

L’exemple ci-dessous a été généré avec ChatGPT mais aurait pu aussi l’être avec hyperwriteai.com ou plusieurs autres intelligences artificielles génératives.

Voici la requête :

User

Vous êtes un spécialiste du voyage d’affaires.

User

planifier pour moi un voyage de 4 jours de Montréal à Toronto du 5 mars au 9 mars pour une personne en me proposant le transport le moins dispendieux et le plus rapide et l’hôtel 4 étoiles et + le plus près du centre des congrès à un coût/bénéfice le plus avantageux

Et la réponse :

ChatGPT

Pour un voyage d’affaires de Montréal à Toronto, l’efficacité et le confort sont primordiaux, tout en gardant un œil sur le budget. Voici une proposition qui combine transport économique et rapide, ainsi qu’un hébergement de qualité près du Metro Toronto Convention Centre, le cœur des affaires et des congrès à Toronto.

Transport Montréal-Toronto

Option recommandée : Train VIA Rail

• Avantages : Confortable, vous permet de travailler pendant le trajet grâce au Wi-Fi gratuit, évite les tracas de l’aéroport.

• Durée : Environ 5 heures.

• Coût : Les tarifs varient, mais en réservant à l’avance, vous pouvez trouver des allers simples en classe économique à partir de 45 $ CAD, ce qui est généralement moins cher et plus pratique que l’avion, en tenant compte du temps d’arrivée à l’aéroport et des éventuels retards.

Hébergement à Toronto

InterContinental Toronto Centre

• Localisation : À côté du Metro Toronto Convention Centre, idéal pour les voyages d’affaires.

• Avantages : 4 étoiles, offre un accès facile aux quartiers d’affaires et de loisirs, dispose de commodités haut de gamme (spa, piscine, restaurant sur place).

• Coût : Les tarifs des chambres varient en fonction de la disponibilité et du moment de la réservation. En général, vous pouvez vous attendre à des tarifs à partir de 250 $ CAD par nuit pour une chambre standard. Les tarifs peuvent être plus avantageux lors de la réservation à l’avance ou via certaines plateformes de réservation offrant des réductions.

Itinéraire Suggéré

Jour 1 : Départ de Montréal (5 mars)

• Prenez le train VIA Rail tôt le matin pour maximiser votre première journée à Toronto.

• Arrivée à Toronto, check-in à l’InterContinental Toronto Centre.

• Journée libre ou réunions préliminaires.

Jour 2 & 3 : Journées de Congrès/Travail (6-7 mars)

• Petit-déjeuner à l’hôtel ou dans un café à proximité.

• Journées consacrées aux activités professionnelles.

• Dîners dans des restaurants proches du centre-ville ou réceptions liées au congrès.

Jour 4 : Dernières Réunions et Retour (8 mars)

• Réunions matinales ou temps libre pour explorer.

• Départ en début d’après-midi via VIA Rail pour retourner à Montréal.

• Arrivée à Montréal en fin de journée.

Conseils supplémentaires

• Réservation Anticipée : Pour le train et l’hôtel, réserver bien à l’avance vous garantira les meilleurs tarifs et disponibilités.

• VIA Rail Discount : Regardez pour des rabais, comme des tarifs pour jeunes professionnels, ou des promotions spéciales.

• Fidélité et Récompenses : Si vous êtes membre de programmes de fidélité avec VIA Rail ou l’hôtel, n’oubliez pas de mentionner votre numéro de membre lors de la réservation pour accumuler des points.

Ce plan combine efficacité et confort, tout en restant conscient des coûts, ce qui est essentiel pour un voyage d’affaires réussi.

Requête additionnelle

User

Avec un budget de $120/jour suggérez moi les meilleurs restaurants aux environs pour le déjeuner et le souper de chaque jour de ce périple

Et la réponse :

ChatGPT

Avec un budget de 120 $ CAD par jour pour les repas à Toronto, vous pouvez profiter d’une excellente variété de cuisines et d’expériences gastronomiques. Voici des suggestions de restaurants pour le déjeuner et le dîner, en gardant à l’esprit la proximité du Metro Toronto Convention Centre et un bon rapport qualité-prix.

Jour 1 (5 mars) : Arrivée et Exploration

Déjeuner – Pai Northern Thai Kitchen

• Cuisine : Thaïlandaise authentique

• Prix moyen : 20-30 $ CAD par personne

• Description : Pai est connu pour ses saveurs authentiques et son cadre vibrant, parfait pour un déjeuner décontracté mais savoureux.

Dîner – Canoe

• Cuisine : Canadienne contemporaine

• Prix moyen : 60-80 $ CAD par personne

• Description : Situé au 54e étage du TD Bank Tower, Canoe offre non seulement une cuisine raffinée mais aussi une vue imprenable sur la ville. Un dîner ici est une expérience mémorable.

Jour 2 (6 mars) : Congrès/Travail

Déjeuner – The Loose Moose

• Cuisine : Américaine, bar

• Prix moyen : 15-25 $ CAD par personne

• Description : Proche du centre de congrès, c’est l’endroit idéal pour un déjeuner rapide mais satisfaisant avec un grand choix de bières et de plats américains classiques.

Dîner – Terroni

• Cuisine : Italienne

• Prix moyen : 30-50 $ CAD par personne

• Description : Terroni est réputé pour sa cuisine italienne authentique, ses pâtes faites maison et sa sélection de vins. Un choix parfait pour un dîner relaxant après une journée de travail.

Jour 3 (7 mars) : Aventures Urbaines

Déjeuner – Assembly Chef’s Hall

• Cuisine : Variée, food hall

• Prix moyen : 10-20 $ CAD par personne

• Description : Ce food hall regroupe plusieurs stands de restauration de qualité, offrant une grande variété de choix, parfait pour un déjeuner rapide et savoureux.

Dîner – Miku

• Cuisine : Japonaise, sushi

• Prix moyen : 40-60 $ CAD par personne

• Description : Miku est célèbre pour son Aburi Sushi. Ce restaurant offre une expérience culinaire japonaise moderne dans un cadre élégant au bord de l’eau.

Jour 4 (8 mars) : Dernières Réunions et Retour

Déjeuner – Momofuku Noodle Bar

• Cuisine : Asiatique, ramen

• Prix moyen : 15-25 $ CAD par personne

• Description : Pour un déjeuner rapide mais mémorable, Momofuku Noodle Bar propose d’excellents bols de ramen et d’autres plats asiatiques innovants.

Dîner – Richmond Station

• Cuisine : Bistrot, Canadienne

• Prix moyen : 30-50 $ CAD par personne

• Description : Un restaurant détenu par un chef gagnant de “Top Chef Canada”, connu pour ses ingrédients locaux et ses plats créatifs.

Conseils pour rester dans le budget

• Eau : Demandez de l’eau du robinet au lieu de boissons en bouteille pour accompagner vos repas.

• Spécialités du jour : Optez pour les spécialités du jour ou les menus fixes qui offrent souvent un bon rapport qualité-prix.

• Réservations : Faire des réservations peut aider à éviter les attentes et à planifier votre budget.

Ce plan de repas combine une variété de cuisines et d’expériences, de l’authentique cuisine thaïlandaise à la fine cuisine canadienne, tout en restant dans votre budget quotidien.

ChatGPT peut faire des erreurs.

Comment faire du GEO pour s’adapter à l’intelligence artificielle générative?

C’est d’abord la recherche de l’Université Princeton, GEO: Generative Engine Optimization de novembre 2023, qui est venu bouleverser le relatif statu quo du référencement. Les auteurs décrivent ainsi les transformations qu’apportent l’intelligence artificielle générative.

The recent success of large language models (LLMs) however has paved the way for better systems like BingChat, Google’s SGE, and perplexity.ai that combine the strength of conventional search engines with the flexibility of generative models. We dub these new age systems generative engines (GE) because they not only search for information, but also generate multi-modal responses by synthesizing multiple sources. From a technical perspective, generative engines involve retrieving relevant documents from a database (such as the internet) and using large neural models to generate a response grounded on the sources, to ensure attribution and a way for the user to verify the information.

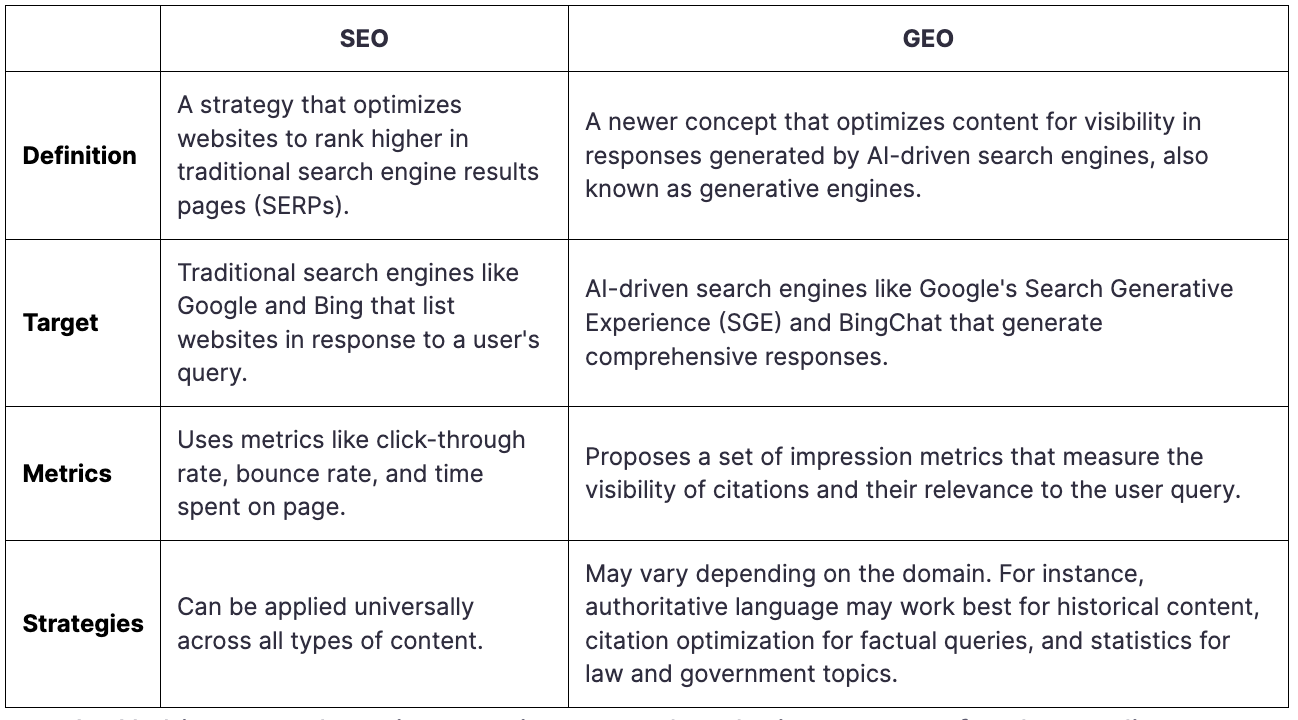

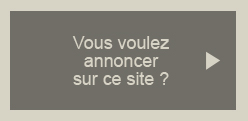

Les entreprises devront donc, au risque de ne perdre de la clientèle, s’adapter rapidement à ces changements. Selon SEO.AI voici les différences entre le SEO et le GEO.

Selon SearchEngineLand, les techniques qui devront être utilisées afin de bien se positionner face à ce nouveau paradigme sont :

Tested techniques. Nine optimization tactics were tested across 10,000 search queries on something that “closely resembles the design of BingChat”:

1. Authoritative: Content was modified to be more persuasive while making authoritative claims.

2. Keyword Stuffing: More keywords were added to match the query.

3. Statistics Addition: Quantitative statistics were added, instead of qualitative discussion.

4. Cite Sources: Relevant citations were added.

5. Quotation Addition: Quotations from credible sources were added.

6. Easy-to-Understand: Simplified the language.

7. Fluency Optimization: Improved the fluency.

8. Unique Words: Added to content wherever possible.

9. Technical Terms: Added to content wherever possible.

The search query data set was compiled from Google, Microsoft Bing, Perplexity.AI Discover, GPT-4 and other sources.

Topic-specific optimization. The report said:

• “Overall, our analysis suggests that website owners should strive towards making domain-specific targeted adjustments to their websites for higher visibility.”

For example, adding citations increased visibility for Facts, while focusing on Authoritative optimizations improved performance in the Debate and History categories.

To be clear, when the paper discusses “domains” it’s talking more about broad categories, not an online domain name. This would also be true in SEO – specific optimizations are different in healthcare versus payday loans.

Les marketeurs numériques de même que les développeurs web ont donc beaucoup de pain sur la planche pour ajuster les présences web de leurs clients à ces nouvelles réalités.

Article publié le jeudi, 29 février 2024 sous les rubriques ChatGPT, IA, intelligence Artificielle, LLM, Marketing de contenu, Marketing des univers virtuels et Moteurs de recherche et référencement de sites Web.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Generative Engine optimization, GEO, les éclaireurs du Numérique, SEO vs GEO, SMMW24.

La formule “question-réponse” aussi communément appelée FAQ (Frequently Asked Questions) est tout à fait appropriée pour augmenter les visites sur votre site web et améliorer votre référencement.

Souvent les gens ne cherchent pas les réponses (puisqu’ils ne les connaissent pas) mais plutôt, il inscrivent leurs questions dans les moteurs de recherches. Si ces questions se retrouvent dans votre site, que la réponse est adéquate et que de surcroit, votre site a mis en place Schema.org qui est un standard de web sémantiques (qui sont des microdonnées permettant aux robots d’indexation de saisir plus précisément le sens des pages indexées) vous serez bien positionné pour améliorer votre pertinence et donc votre référencement. Au préalable, il est intéressant de vérifier avec vos clients quelles questions ils se posent et de valider à l’aide de recherches de mots clés et d’autres techniques d’investigation web, les questions précisent que recherchent les internautes/clients. Vous pourrez donc adéquatement garnir votre FAQ.

De plus, si chacune des questions, sur la page générale de la FAQ, se trouve à être des hyperliens menant à une page avec son URL propre, dont le titre inclut la question et qu’elle se retrouve de surcroit avec un méta-tag H1, vous venez d’être très efficace pour l’un des nombreux critères favorisant votre bon positionnement dans les moteurs de recherche (comme Google par exemple).

Par ailleurs, si vous parlez de votre sujet ou de votre organisation sur les médias sociaux, il est possible qu’on vous pose des questions, dont les questions qui sont déjà dans votre FAQ. Si vous avez déjà plusieurs URLs de ces questions et que vous pouvez répondre succinctement et y ajoutant votre lien menant vers la réponse sur votre site, vous augmenterez aussi le nombre d’hyperliens externes menant vers votre site. Il s’avère que c’est aussi l’un des autres critères importants d’un bon positionnement web, que d’avoir un grand nombre d’hyperliens signifiants, menant vers votre site.

Ces tactiques d’optimisation de la formule « question-réponse » sont donc à même d’améliorer grandement votre présence web.

Article publié le lundi, 15 janvier 2024 sous les rubriques Marketing 2.0, Marketing Internet, marketing mobile et Moteurs de recherche et référencement de sites Web.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

La French Connection se décrit comme suit :

Podcast international sur la sécurité et le hacking. Nouvelles et opinions du Québec et de l’Europe!

Il est animé par Patrick Mathieu et Jacques Sauvé. D’ailleurs voici la présentation que Jacques Sauvé en fait sur Twitter:

Bon…si vous ne savez pas trop quoi faire en fin d’semaine, vous pouvez écouter cet épisode spécial de La French Connection !

J’avais mis une vidéo ici au mois d’août demandant de l’aide à comprendre la Loi C-18 des Libéraux, le blocage des nouvelles sur Meta, etc. Je n’y comprends rien !

Je voulais en discuter avec quelqu’un qui pourrait nous éclairer sur les enjeux, donc Pat et moi avons invité

@MichelleBlanc

!! Vraiment cool qu’elle ait accepté de faire ça avec nous.

Bonne écoute !

Pour écouter c’est ici : https://securite.fm/special/2023/11/30/episode-0x233.html#7a667d3e

Article publié le mardi, 5 décembre 2023 sous les rubriques Edito sans question, Marketing Internet, Médias auxquels je collabore, Médias qui sollicitent mes avis, Medias et Internet et Moteurs de recherche et référencement de sites Web.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Bill C-18, crise des médias, La French Connection.

Il m’arrive souvent d’avoir des mandats de diagnostic de site web. J’en ai eu dans plusieurs secteurs d’activité. Récemment, j’ai travaillé pour une organisation du secteur touristique. Comme plusieurs organisations, ils ont donné le mandat de création de leur site web à une agence généraliste. Une agence qui fait de la pub, du placement, des médias sociaux, de la stratégie et du web. Ils semblent être bons dans tout. Ils ont fait un très beau site, mais disons qu’ils ne sont vraiment pas cassé la tête pour faire un site efficace. Personnellement, je préfère travailler avec des développeurs de site plutôt qu’avec des agences. Ils sont souvent plus consciencieux avec le code, les fonctionnalités, les plugiciels et la performance du site. En outre, ils développent sans personnaliser à l’excès et ils choisissent des plugiciels qui ne vont pas restreindre les performances du site. En outre, lorsque vient le temps de faire une mise à jour, le site ne plante pas parce que les plugiciels sont aussi mis à jour.

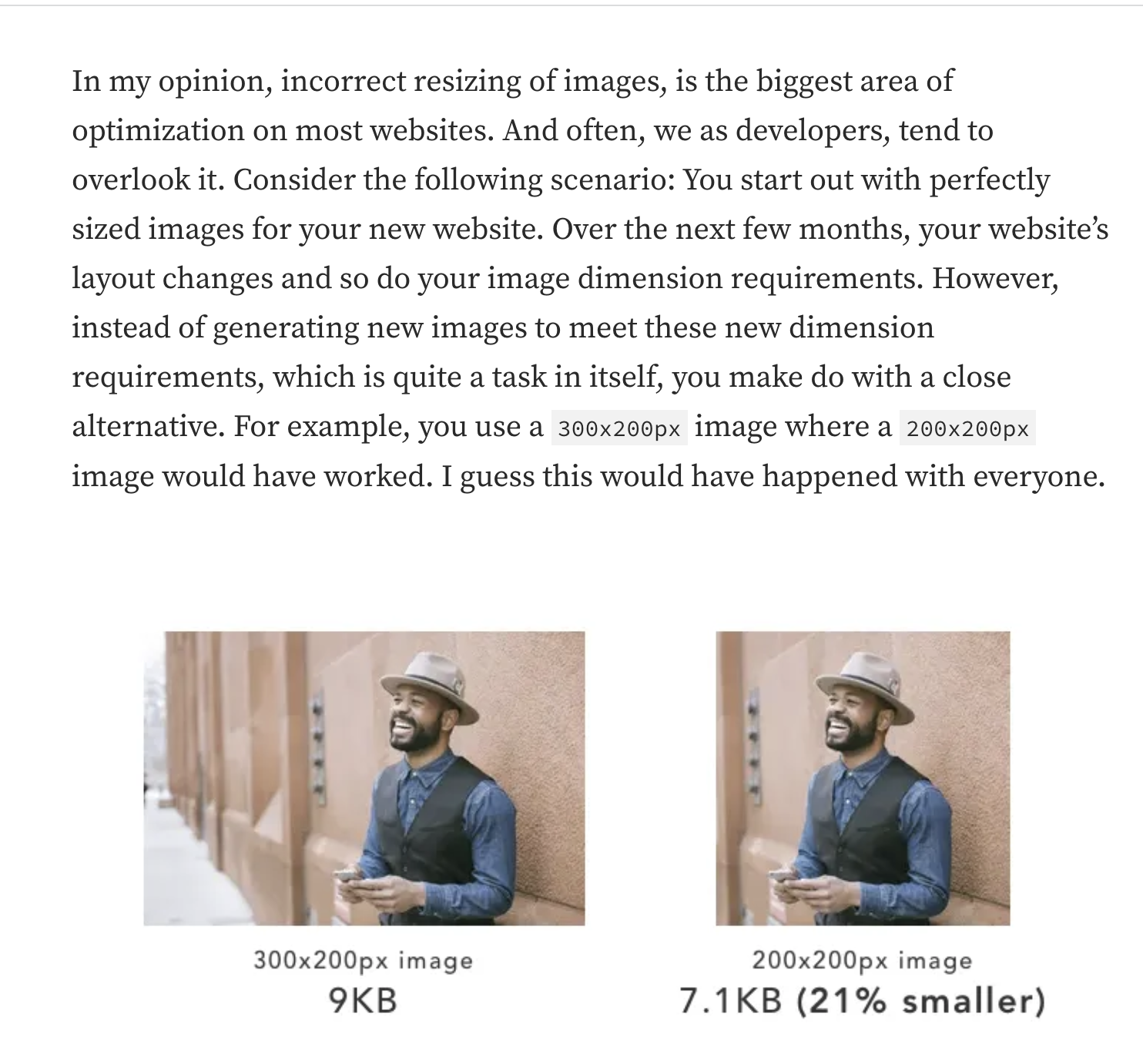

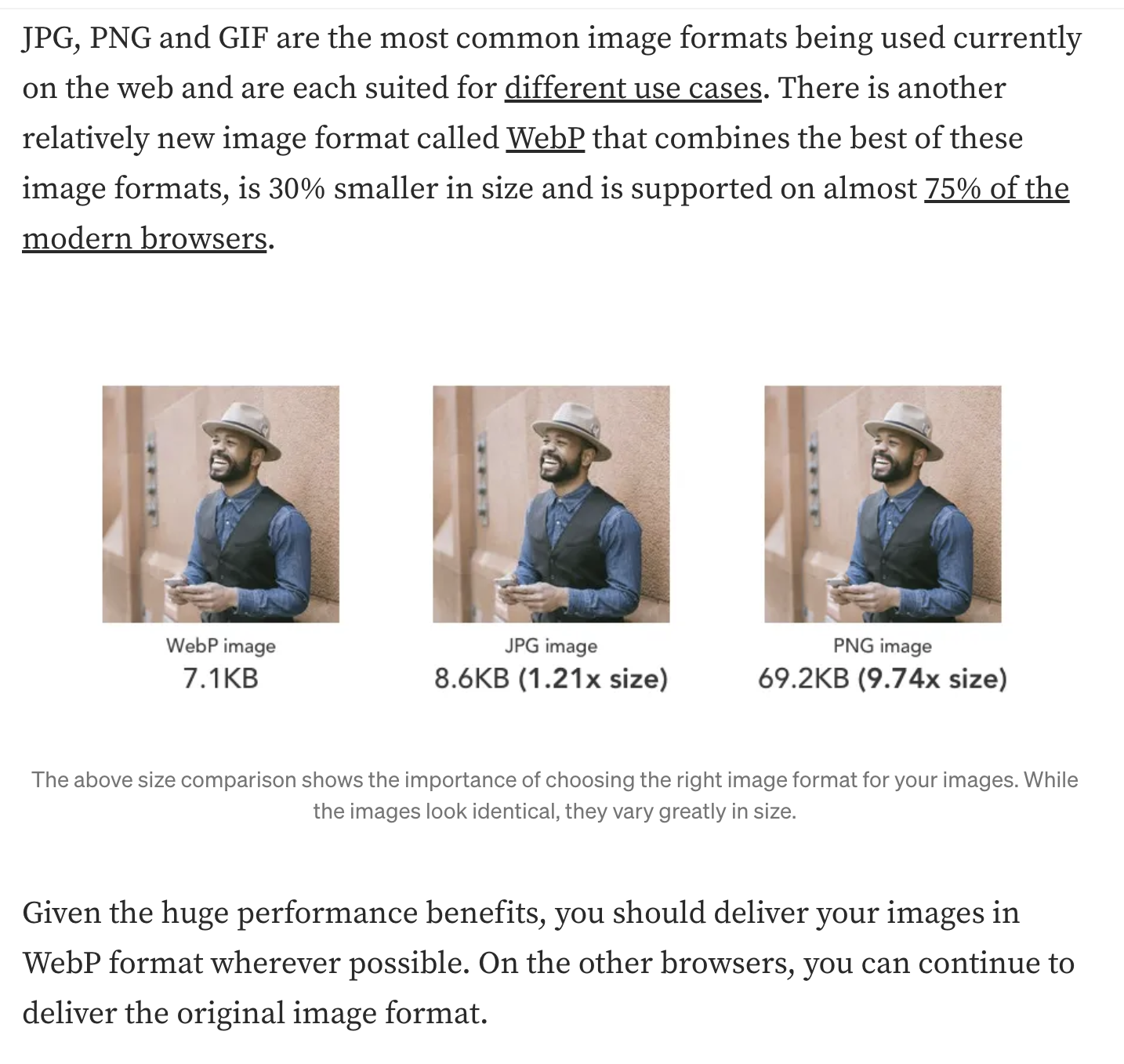

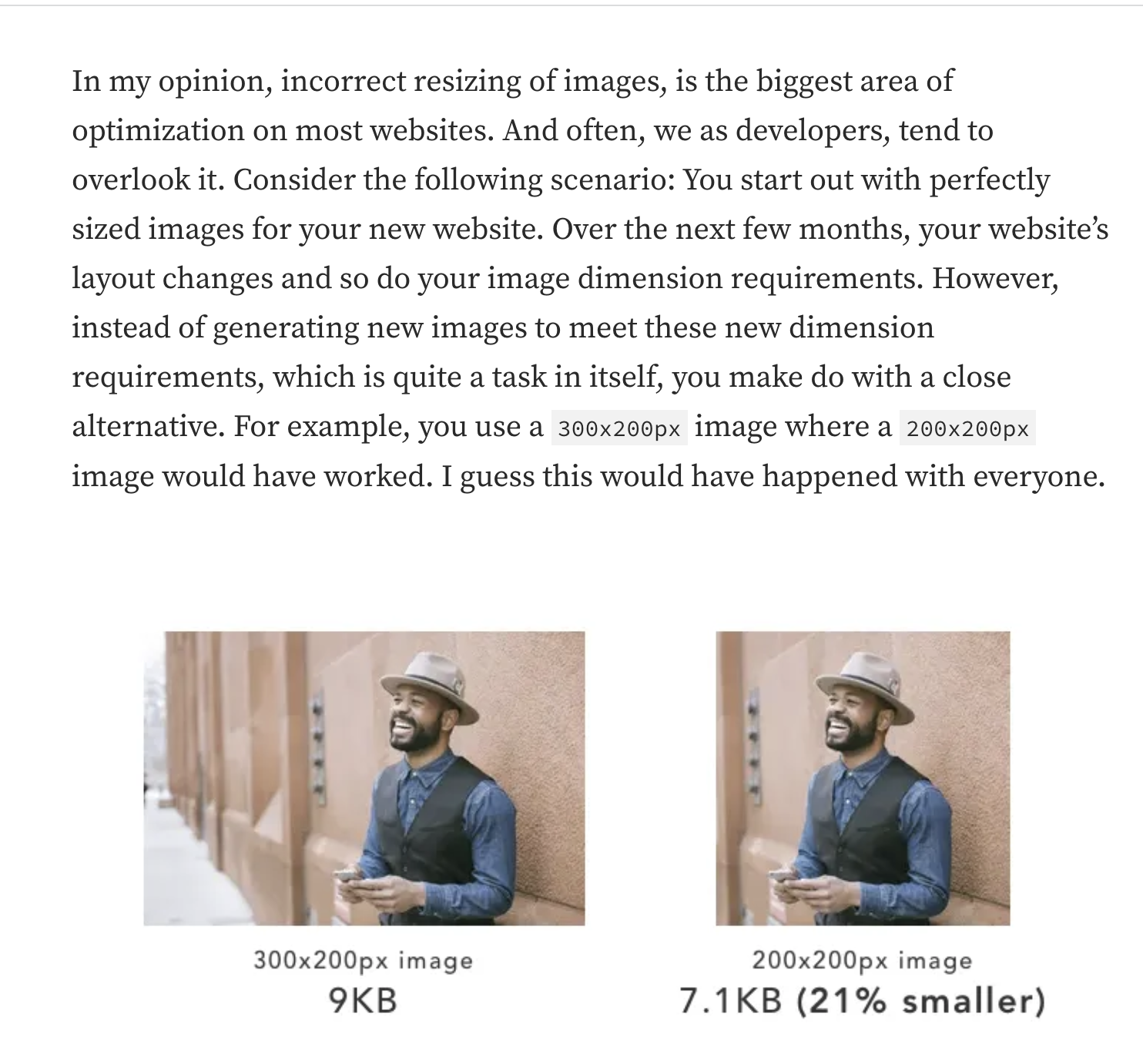

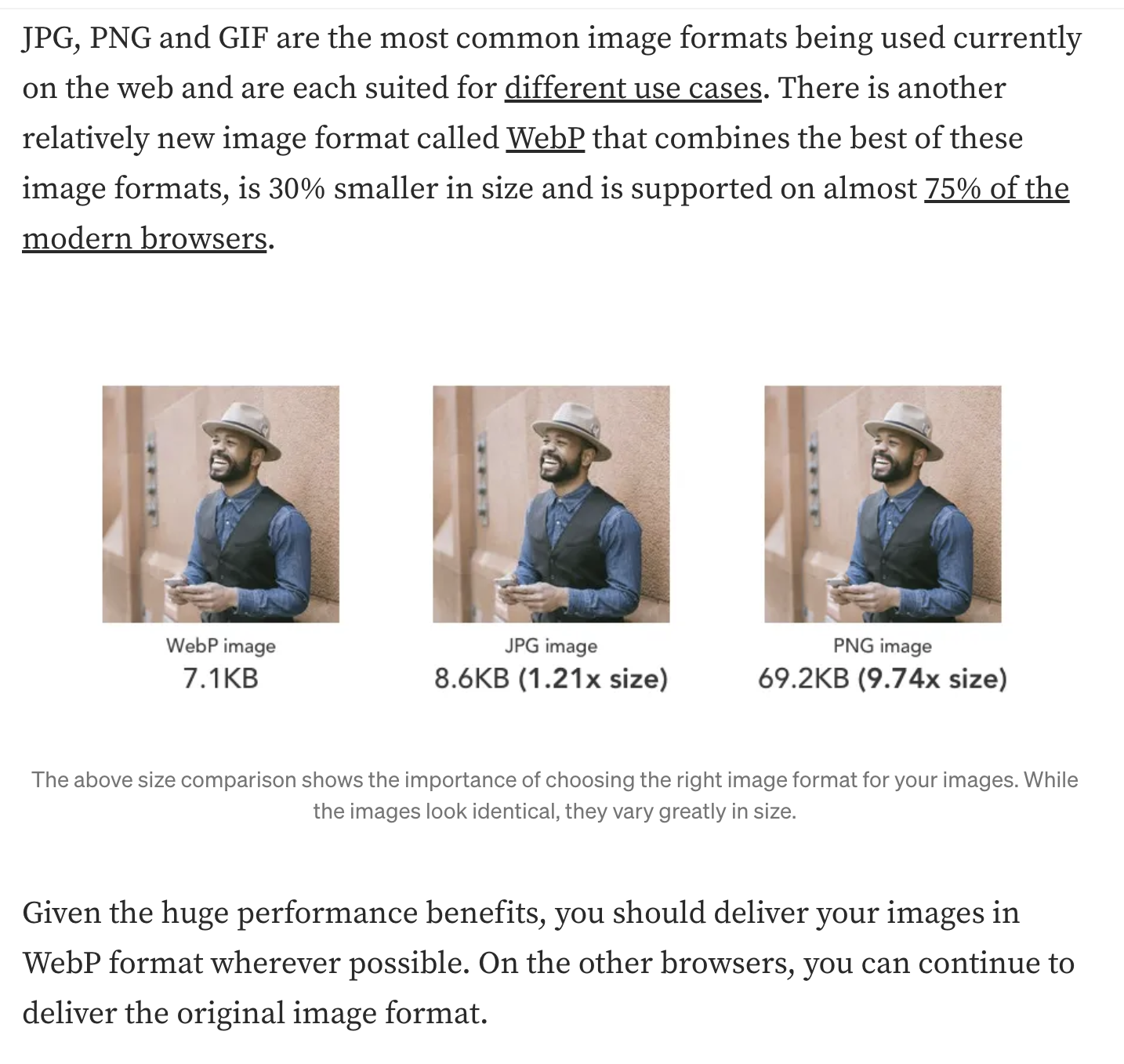

Toujours est-il que l’un des gros problèmes des acteurs touristiques, en plus de choisir les mauvaises agences avec qui ils travaillent, est qu’ils valorisent le visuel. Je les comprends tout à fait. On veut faire rêver le touriste et quoi de plus efficace qu’une photo léchée qui le fera rêver. Or, souvent, ils ont des photos époustouflantes, mais qui sont dans un format et avec une grosseur qui ralentissent énormément le site web ce qui empêche l’internaute de prendre connaissance des contenus. Ils ne réalisent pas (comme vous le voyez dans les photos ci-dessous tirées de https://codeburst.io/5-steps-to-speed-up-your-image-heavy-website-65c874a86966 ) que l’œil ne voit pas vraiment la différence de qualité sur le web.

L’une des solutions est d’encoder vos images avec le standard WebP, plutôt qu’avec le PNG ou le JPEG habituel. Cela réduira déjà la grosseur de l’image de 25% à 34%, ce qui est déjà énorme sur une page web contenant plusieurs images.

Article publié le vendredi, 7 juillet 2023 sous les rubriques Innovation, Marketing 2.0, Marketing Internet, marketing mobile, Moteurs de recherche et référencement de sites Web, Outils et références, stratégie numérique, stratégie web, Stratégies de commerce électronique et Technologies Internet.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : diagnostic de site web, GIF, JPEG, PNG, WebP.

Ce matin, une bonne amie me partage cette nouvelle et me demande ce que j’en pense.

« D’ici 2025, 90 % du contenu en ligne sera généré par l’IA »

Ma réponse fut: J’ai de gros doutes!

Voici donc une réponse plus détaillée…

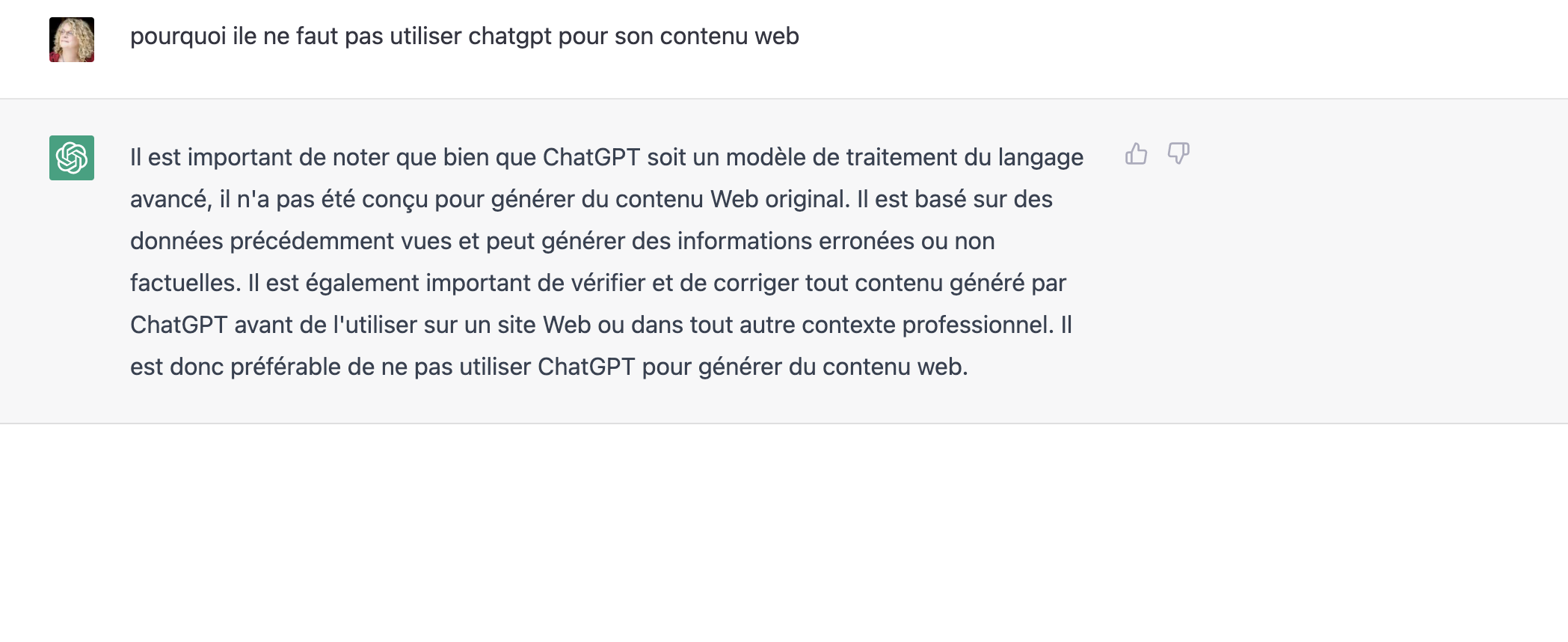

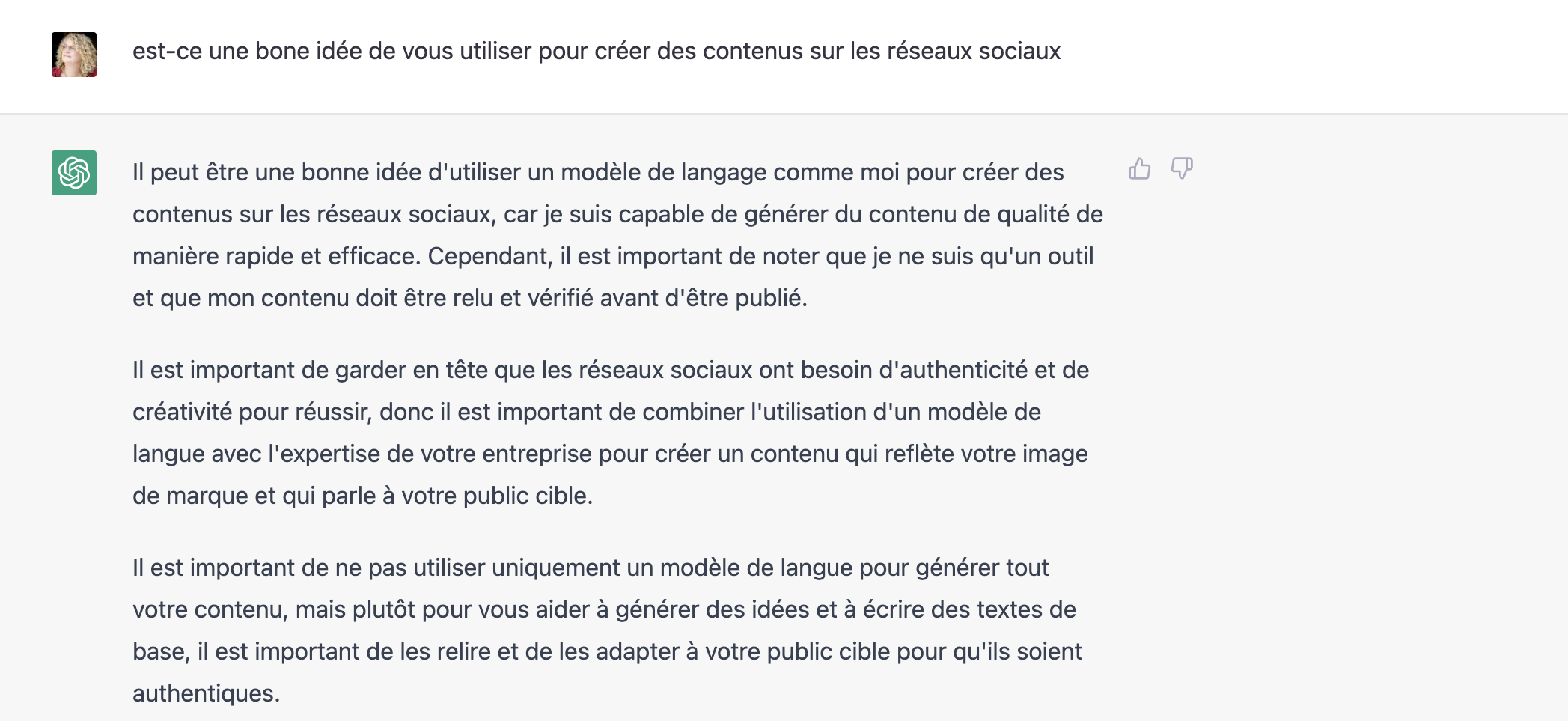

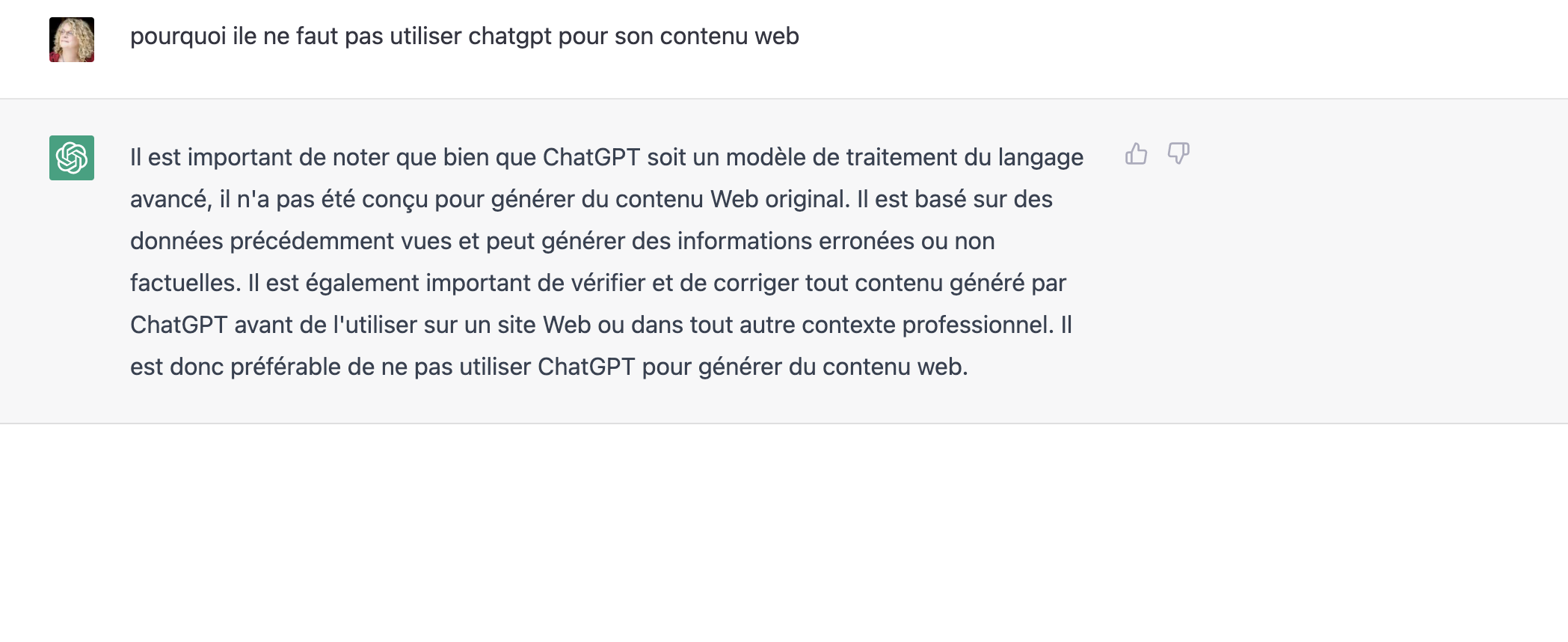

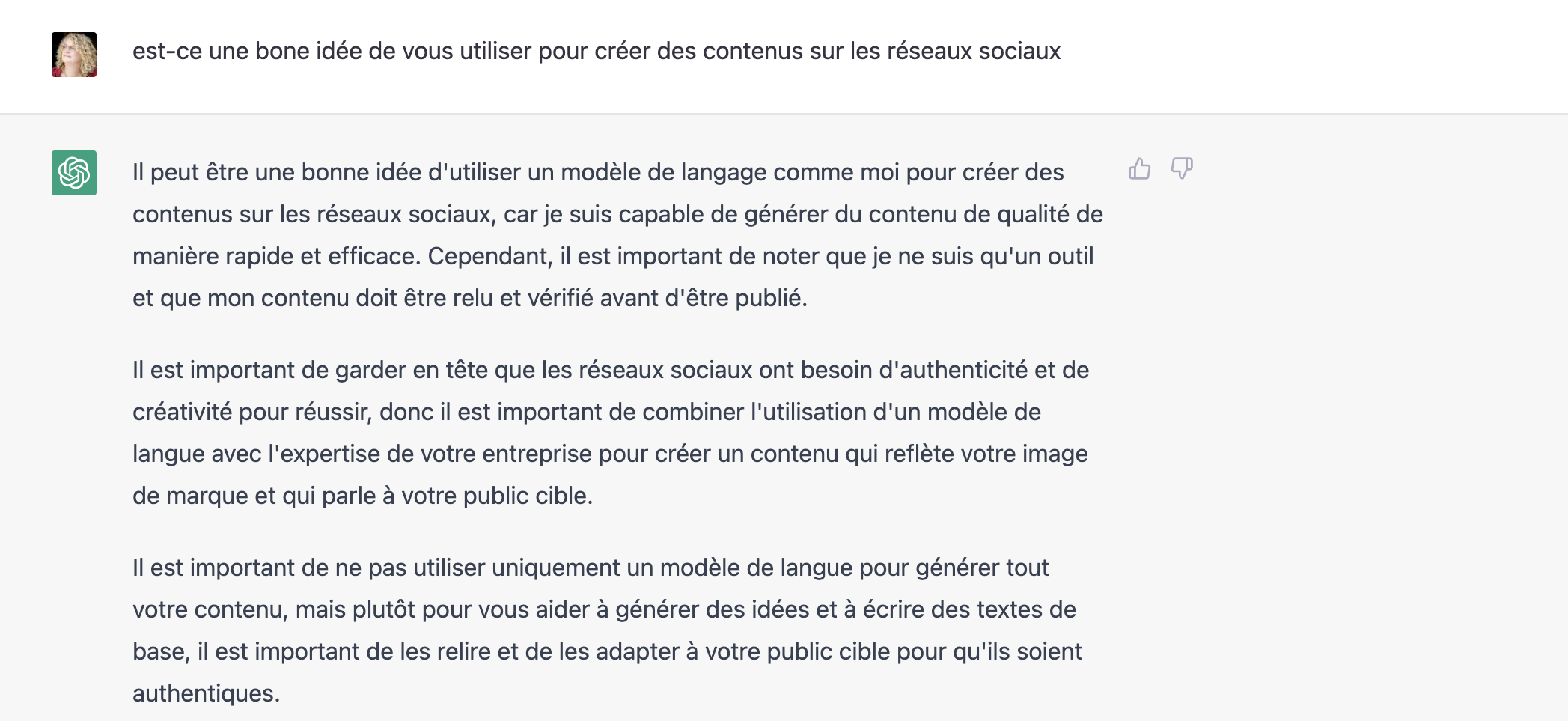

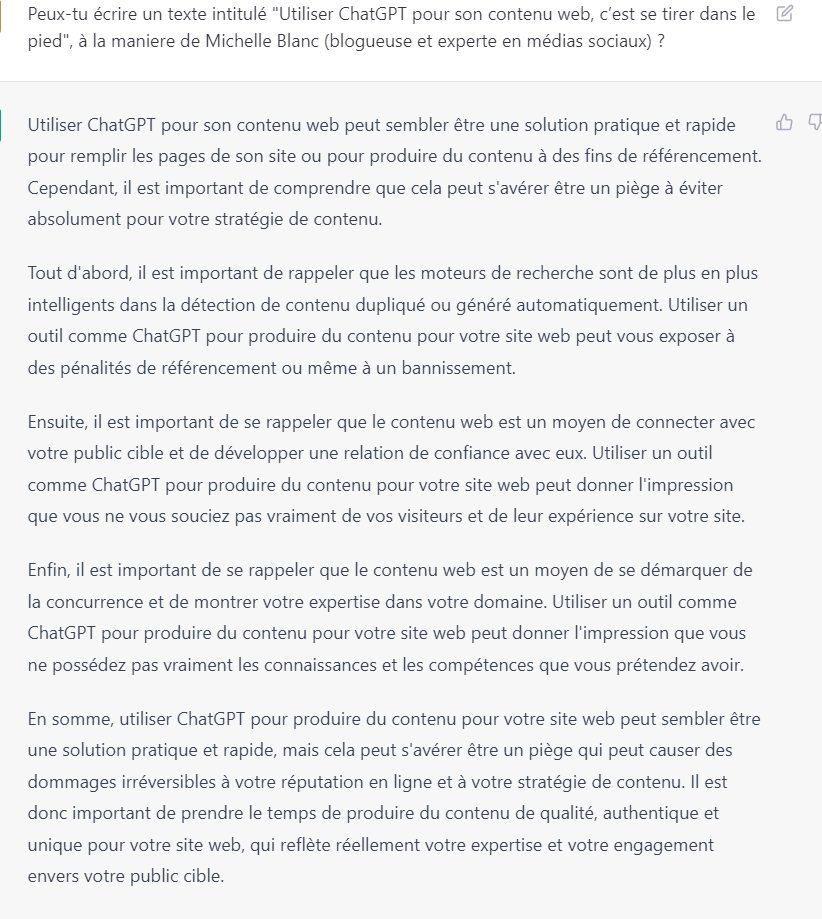

ChatGPT est un outil qui a été développé à partir de contenus glanés sur le Web de 2020 à 2021. Il n’est donc pas « à jour » pour des contenus qui traiteraient de sujets contemporains. Par ailleurs, le programme de ChatGPT est conçu pour ne pas créer de contenus négatifs ou toucher à des sujets sensibles comme de la violence, le sexe ou des contenus considérés dangereux. De plus, ce logiciel a des biais le rendant incapable de prendre position. Il se doit d’être générique, sans danger, vrai et instructif. Il ne pourra donc pas décortiquer une situation réelle et présenter les pour et les contre d’une problématique. En outre, il ne présentera donc qu’un consensus de ce qu’il a collecté des contenus au moment de sa mise en ligne. Les consensus, comme c’est souvent le cas, évoluent dans le temps et peuvent changer drastiquement. Mais l’argument le plus important est que ChatGPT n’a aucune créativité. Il n’est pas capable d’être authentique, ce qui est la base même d’un contenu qui pourrait devenir viral ou simplement intéresser les lecteurs. Bien que j’étais spéciale durant mon enfance et que j’aimais lire les encyclopédies, on s’entend que c’est loin d’être le cas pour tous.

Utiliser ChatGPT et être pénalisé par les moteurs de recherches.

Disons que vous êtes un luthier et que vous utilisez chatGPT pour générer des textes pour votre site web. Les contenus que générera ChatGPT existent donc déjà sur le web. Il en fera une synthèse et vous la présentera. Imaginez aussi que l’un de vos compétiteurs a la même idée et génère lui aussi des contenus pour parler du même sujet. Il y a de fortes chances que vous soyez tous les deux pénalisés pour contenus dupliqués, ce qui est contraire à l’algorithme de Google entre autres. Vos contenus en plus de ne pas être authentique, ne seront donc pas non plus originaux.

Par ailleurs, selon searchenginejournal, les contenus générés automatiquement sont contre les directives aux webmestres de Google.

Automatically Generated Content Is Against Google’s Webmaster Guidelines

Regardless of the tools used to create it, content written by machines is considered automatically generated. As Mueller is quick to point out, Google’s position on auto generated content has always been clear:

“For us these would, essentially, still fall into the category of automatically generated content which is something we’ve had in the Webmaster Guidelines since almost the beginning.

And people have been automatically generating content in lots of different ways. And for us, if you’re using machine learning tools to generate your content, it’s essentially the same as if you’re just shuffling words around, or looking up synonyms, or doing the translation tricks that people used to do. Those kind of things.

My suspicion is maybe the quality of content is a little bit better than the really old school tools, but for us it’s still automatically generated content, and that means for us it’s still against the Webmaster Guidelines. So we would consider that to be spam.”

Mais Google est-il capable d’identifier les contenus générés automatiquement?

ChatGPT travaille déjà et a promis d’inclure un filigrane « watermark » dans ses contenus, permettant d’identifier les contenus générés automatiquement. Par ailleurs, les recherches en ce domaine précèdent les innovations de ChatGPT. Cette preuve de tricherie, serait cachée dans des lettres, des mots ou des tournures de phrases, qui bien qu’ils apparaissant aléatoires à nos yeux, avec la clé cryptographique du propriétaire de ChatGPT, il serait aisé d’identifier le faussaire. Et ce, même s’il changeait certains mots pour tenter de faire passer un contenu généré automatiquement, par la création d’un rédacteur. Vous pouvez avoir les détails de cette procédure dans l’article de Techcrunch, OpenAI’s attempts to watermark AI text hit limits, It’s proving tough to rein in systems like ChatGPT.

Il y a certainement encore des débats sur l’efficacité ou non et l’approche propriétaire ou open source d’en tel filigrane, mais la conclusion de l’article de Techcrunch est sans équivoque. Tôt ou tard, les fourbes se feront pincer…

“You could worry that all this stuff about trying to be safe and responsible when scaling AI … as soon as it seriously hurts the bottom lines of Google and Meta and Alibaba and the other major players, a lot of it will go out the window,” Aaronson said. “On the other hand, we’ve seen over the past 30 years that the big internet companies can agree on certain minimal standards, whether because of fear of getting sued, desire to be seen as a responsible player, or whatever else.”

(notez que ce qui suit et est tiré de ChatGPT, sont des images et que leurs contenus sont donc invisibles aux moteurs de recherches. Si elles avaient des filigranes, ils seraient aussi invisibles…)

MAJ

Une nouvelle application Québécoise permettrais d’identifier les contenus autogénérés selon l’article La chasse au ChatGPT est ouverte. il s’agit de Detector https://detector.dng.ai/fr

MAJ2

Le pote Yves William sur Facebook, demande à ChatGPT ce qu’il pense de ce billet. Voici le résultat…

Article publié le vendredi, 20 janvier 2023 sous les rubriques Blogue, Blogues d'affaires, ChatGPT, cybersécurité, Marketing de contenu, Moteurs de recherche et référencement de sites Web et stratégie de contenus.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Detector.dng.ai, IA.

Voici le Cinquième cours de Marketing Entrepreneurial que j’enseigne à HEC Montréal. Il traitera de:

Analyses primaire et secondaire

Identifier le marché et les compétiteurs

Analyser leurs présences web

Analyser ceux qui communiquent avec eux

Comprendre ce qu’ils offrent et à quel coût

Faire des tableaux comparatifs

Le 1er cours qui est une revue sociodémographique des médias sociaux est ici

Médias sociaux et le web pour les entrepreneurs (le web ce n’est pas une question de budget, mais de philosophie)

le 2e cours

Qu’est-ce que le marketing de contenus et pourquoi la publicité coute cher et que le contenu est ROI

le 3e cours

Rédiger pour le web et les médias sociaux de façon stratégique

le 4e cours

Monitorage, veille et comment chercher sur le web

Article publié le lundi, 7 novembre 2022 sous les rubriques Marketing 2.0, Marketing de contenu, Marketing Internet, Mon cours à HEC Montréal, Moteurs de recherche et référencement de sites Web, stratégie de contenus et stratégie numérique.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : analyse compétitive, benchmark web.

Voici le Quatrième cours de Marketing Entrepreneurial que j’enseigne à HEC Montréal. Il traitera de:

• Les types de veille

• Monitorage organisationnel

• Les outils de monitorage et de veille

• Monitorage collaboratif

• Les « sites d’autorités »

• Les influenceurs du secteur

• Cas DessinsDrummond

Le 1er cours qui est une revue sociodémographique des médias sociaux est ici

Médias sociaux et le web pour les entrepreneurs (le web ce n’est pas une question de budget, mais de philosophie)

le 2e cours

Qu’est-ce que le marketing de contenus et pourquoi la publicité coute cher et que le contenu est ROI

le 3e cours

Rédiger pour le web et les médias sociaux de façon stratégique

Article publié le mardi, 11 octobre 2022 sous les rubriques Mon cours à HEC Montréal, Moteurs de recherche et référencement de sites Web et Veille stratégique et Internet.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : DessinsDrummond.

Voici le Troisième cours de Marketing Entrepreneurial que j’enseigne à HEC Montréal. Il traitera de:

• La rédaction Web, storyline et les diverses politiques éditoriales

• Comment écrire pour le Web

• L’analyse de mots-clés

• L’importance des titres, des éléments du corps du texte et des balises méta

• Les hashtag

• L’infolettre

• Les diverses politiques : d’utilisation du web pour les employés, éditoriale, des commentaires

• Charte éditoriale

• Calendrier éditorial

• La règle des tiers en photographie

Le 1er cours qui est une revue sociodémographique des médias sociaux est ici

Médias sociaux et le web pour les entrepreneurs (le web ce n’est pas une question de budget, mais de philosophie)

Et le 2e cours

Qu’est-ce que le marketing de contenus et pourquoi la publicité coute cher et que le contenu est ROI

Article publié le vendredi, 30 septembre 2022 sous les rubriques Marketing 2.0, Marketing de contenu, Marketing Internet, Médias sociaux, Mon cours à HEC Montréal, Moteurs de recherche et référencement de sites Web, stratégie de contenus, stratégie numérique et stratégie web.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.