Depuis plusieurs années, la croissance des GAFAMs se fait beaucoup par acquisition. Il en est de même pour Google. Lorsqu’on remarque une nouvelle fonctionnalité, un nouveau service ou un nouveau média social qui semble lever et déranger le statu quo, on l’acquiert et on l’intègre à son écosystème. C’est ce que Google avait fait entre autres avec Urchin qui devient Google Analytics ou Where 2 Technologies qui devient Google Map. Si cela n’est pas possible, on le copie et on tente de le compétitionner. C’est ce qu’avait fait Google avec Facebook et Twitter il y a quelques années et créant les maintenant défunts Google Wave et Google Plus. Il en est de même pour Facebook qui a acquis Instagram, et plus récemment avec Microsoft qui a investi massivement en « développant un partenariat » avec OpenAI (qui détient Chat GPT).

Comme je le disais dans mon billet La nouvelle frénésie des GAFAM qui se cherchent, la frénésie actuelle est celle de l’intelligence artificielle générative. À ce chapitre Google est déjà très avancé avec son IA Google DeepMind et son application AlphaFold qui a déjà modélisé 200 millions des protéines connues de l’homme en moins d’un an. Elle a aussi eu d’énormes succès avec AlphaGo, son programme d’intelligence capable de jouer eu jeu Go, le jeu le plus ancien du monde et qui est plus complexe que les échecs.

Par contre on ne peut pas dire qu’elle bat des records avec son Google Gemini. Il est donc très surprenant qu’elle décide, pratiquement sur un coup de tête, d’inclure son mal aimé Gemini dans sa vache à lait qu’est le moteur de recherche. En effet, Google utilisera l’IA Gemini pour faire un résumé des réponses aux questions des internautes, reléguant les résultats naturels et payants, qui existent depuis 20 ans, sous un résumé intitulé « AI Overview ». On peut en voir un exemple dans l’article de The Verge que je reproduis ici (et qui ne semble pas encore disponible au Canada).

Source: TheVerge

Il faut comprendre que Google a le souffle dans le dos venant de Bing (qui a intégré Chat GPT) , de Perplexity qui est le premier moteur de recherche à avoir utilisé l’IA et du fait que de très nombreux jeunes utilisent désormais TikTok ou YouTube, comme moteur de recherche. Google n’a donc pas le choix de se réinventer.

Mais ça sent la panique!

On va rappeler que Google a dû fermer la portion de génération d’images de Gemini pour cause de wokisme trop évident. Alors qu’on demandait à Gémini de nous faire des soldats nazis en 1942, ils étaient afrodescendants ou asiatiques. Ce qui de toute évidence est loin de la réalité. Ceux qui ont eu la chance de tester le « AI Overview » ont eu le même genre de déception. En effet, Google suggère de mettre de la colle et des roches dans les ingrédients de la pizza. Disons que ça n’aide en rien Google à donner confiance aux internautes d’utiliser son IA. En outre, Entretemps, je vous invite à lire en complément, l’article **Google vs. Perplexity AI: A Product Manager’s Perspective**.

Article publié le jeudi, 13 juin 2024 sous les rubriques ChatGPT, Google +, Google Plus, Innovation, intelligence Artificielle, LLM, Marketing et IA, Marketing Internet, Moteurs de recherche et référencement de sites Web, Stratégie d'affaires, stratégie web et Technologies Internet.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : AlphaFold, AlphaGo, Bing, ChatGPT, Gémini, Perplexity.

C’est la prédiction de novembre dernier de Sam Altman (fondateur de ChatGPT) qui disait que d’ici 5 ans, 95% de ce que font les marketeurs et les agences serait fait par l’IA qui m’a poussé à expérimenter davantage avec les capacités texte à image de celles-ci. On s’entend qu’éventuellement, nous pourrons faire des publicités visuelles entièrement conçues par l’IA. Il est évident que ça prendra toujours un créatif pour enligner la machine, valider le rendu et corriger le tir. Mais si nous arrivons à cette étape, bien des professionnels de la génération d’image, de rédacteurs de scripts, direction photo, caméraman, éclairage, sono, designer et autres, seront beaucoup moins présents.

La citation de Altman reprise par Jeremiah Owyang sur X :

“Oh, for that? It will mean that 95% of what marketers use agencies, strategists, and creative professionals for today will easily, nearly instantly and at almost no cost be handled by the AI — and the AI will likely be able to test the creative against real or synthetic customer focus groups for predicting results and optimizing. Again, all free, instant, and nearly perfect. Images, videos, campaign ideas? No problem.”

Pour un client j’ai donc décidé de faire des tests. Mon idée générale était d’avoir une jolie femme dans une Lexus convertible sur une route de campagne et qu’elle soit devant une Mercedes et Audi qui sont ses compétiteurs. Voici mon message-guide :

Une femme d’affaires assise dans une Lexus décapotable dépasse une femme dans une BMW décapotable et une autre dans une Mercedes décapotable.

J’ai essayé différents scripts et même un script généré par chatGPT lui-même (parce que l’IA peut même faire du prompt ingeneering) que voici :

Opening Scene: A panoramic view of Charlevoix’s lush landscapes with the St-Lawrence River glistening under the morning sun. Slowly zoom in on a Lexus convertible parked by the roadside, the driver’s side door opening gracefully.

Introducing the Driver: A close-up of the woman’s hand placing the key in the ignition, followed by her confident smile in the rearview mirror. She’s dressed elegantly, symbolizing sophistication and adventure.

On the Road: Aerial shots of the Lexus convertible cruising along the scenic road, with the St-Lawrence River on one side and the rolling hills of Charlevoix on the other. Capture the car’s sleek design and smooth handling as it navigates gentle curves, with the woman’s hair fluttering in the wind.

Interaction with Nature: Include brief stops or slow drives where the woman interacts with the surroundings—pausing to admire a viewpoint over the river, running her hand through a field of wildflowers, or stopping by a local market to greet the vendors.

Golden Hour Drive: As the day progresses, capture the Lexus driving during the golden hour, with the setting sun casting warm hues over the landscapes, highlighting the metallic sheen of the car against the natural beauty of Charlevoix.

Closing Scene: The Lexus convertible comes to a stop at a cliff overlooking the river, now under a twilight sky. The woman steps out, leaning on the car, gazing at the horizon where the river meets the sky, reflecting on the day’s journey.

Action/Storyline: The video tells the story of a journey that merges the thrill of driving a luxury car with the serenity and beauty of Charlevoix’s natural landscapes, emphasizing moments of introspection and connection with nature.

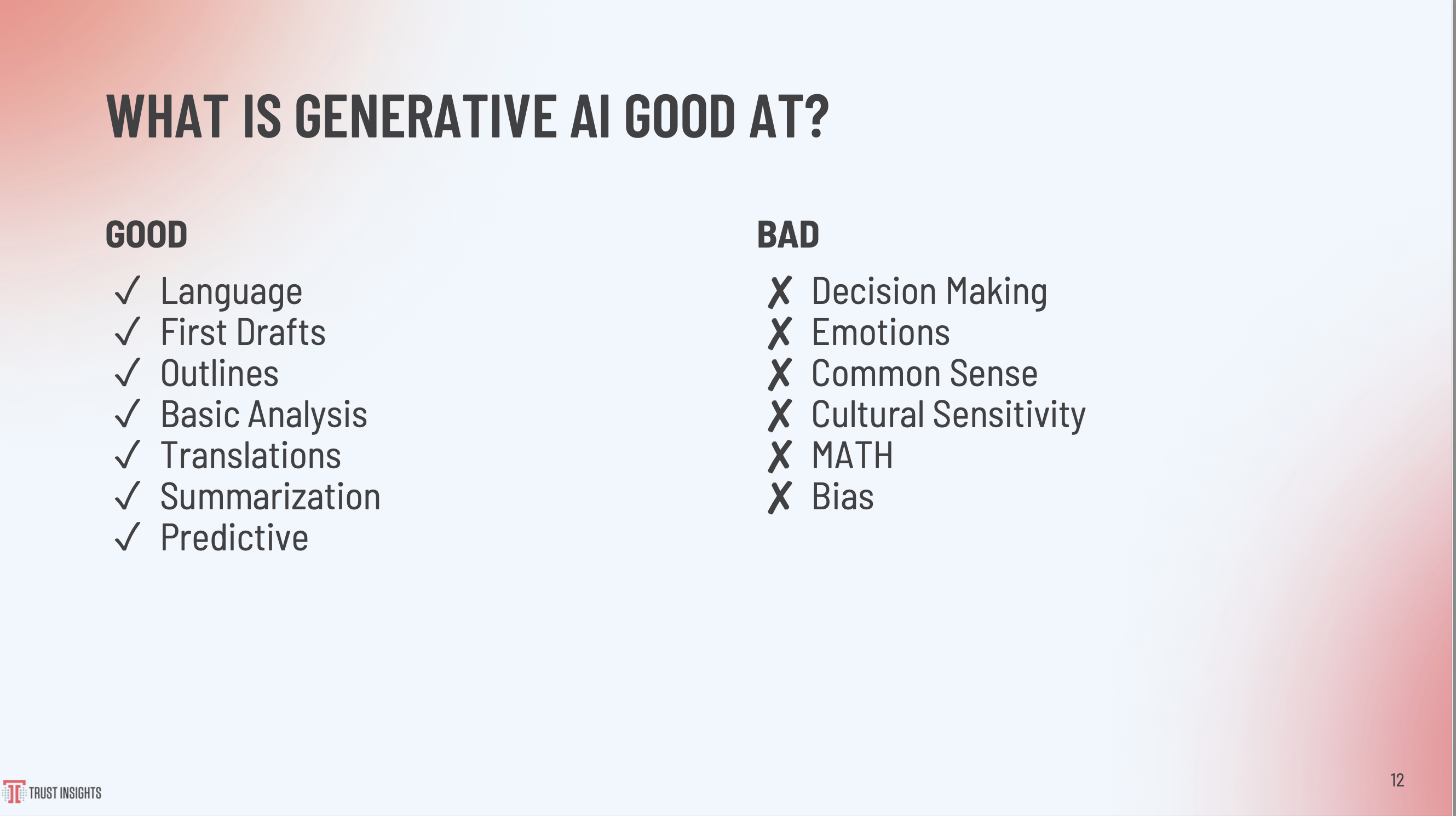

On peut donc facilement conclure que l’éditeur de script publicitaire est déjà dans le trouble. Par contre, les designers, graphistes et illustrateurs ont encore de belles années devant eux. C’est que l’IA a encore plusieurs problèmes. Avec la récente débandade raciste de Gemini, nous savons qu’elle peut être raciste, sexiste et qu’elle se fout de la réalité historique. Mais elle est aussi incapable de compter et de contextualiser. Elle a beaucoup de difficulté avec les mains (qui ont parfois 6 ou 4 doigts) ou avec les membres qui peuvent disparaître ou être ajoutés. En fait, l’IA est extraordinaire pour créer des paysages, des animaux imaginaires et une foule d’autres choses. Mais elle est encore incapable de faire correspondre deux éléments disparates qui ne sont pas du décor. Ainsi, l’IA peut faire une femme de même qu’une très belle voiture, mais semble incapable d’unir ces deux éléments avec cohérence. En voici des exemples :

Fuck-up DALL-E

Fuck-Up Leonardo

Fuck-up Runway

Ainsi donc, peut-être que 95% des tâches des marketeurs et stratèges publicitaires se feront pas l’IA d’ici 5 ans, mais pour maintenant et l’année prochaine, nous sommes encore loin de cette prédiction de Altman… D’ailleurs sur LinkedIn, hermitage Capital disait ceci :

There remain challenges around the potential for misuse of these models to generate fake, harmful, or abusive content. Mitigating these risks through technical solutions and policies is still an active and difficult area of research. The models can still make mistakes, have biases, and lack common sense, making it hard to ensure complete safety. There are also open legal and copyright issues around training data and generated images that need addressing. Environmentally, the computational costs and impacts of developing these large models also needs considering.</blockquote

Article publié le mardi, 2 avril 2024 sous les rubriques IA, intelligence Artificielle et Marketing 2.0.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : DALL-E, Gémini, Leonardo, Runway, Sam Altman.

Depuis des mois j’observe et j’analyse ce qu’on dit de l’IA. Je savais que les bouleversements arrivaient à grands pas. La semaine dernière je suis donc allé à San Diego au Social media Marketing World spécifiquement pour parfaire mes connaissances sur le sujet et j’ai été plus que servie. Oui l’IA va bouleverser le marketing de même que tous les emplois des travailleurs du savoir.

Alors voici donc un petit résumé de certains de mes apprentissages.

Les LLM (Large Language Models) prédisent des mots. En fait ils prédisent le prochain mot dans une suite qui le précède. Cette technologie existait déjà chez Google depuis un certain temps, de même qu’avec certains auto correcteur qui finissaient le mot ou la phrase que nous avions commencé à écrire. Mais disons qu’avec l’apparition de Chat GPT, ça a monté d’un cran. D’ailleurs, au moment d’écrire ces lignes, vous pouvez déjà activer la retranscription de vos discussions sur Zoom, et même éventuellement demander un résumé de vos conversations.

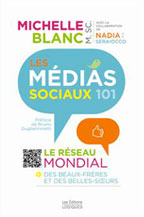

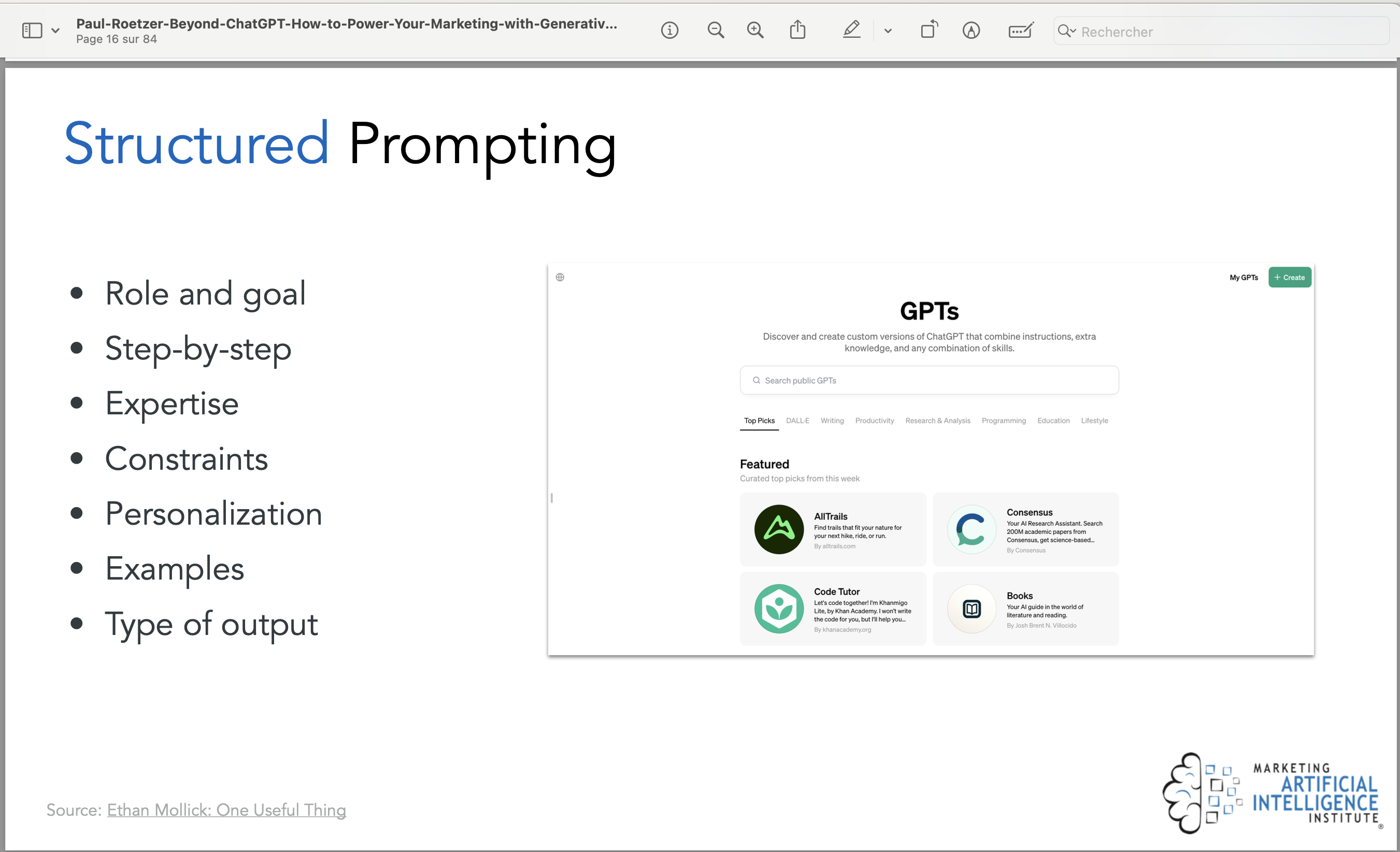

Ça nous amène à la création de « messages-guide » que nous nommons « prompt » en anglais. D’avoir la capacité d’être efficace avec la rédaction de ces messages-guide, deviendra un atout certain pour plusieurs emplois. D’ailleurs l’expert Paul Roetzer, CEO de Marketing AI Institute, disait lors de la conférence de fermeture, que les professeurs universitaires devront bientôt noter les Étudiants sur leurs capacités à rédiger ces fameux « messages-guide » plutôt que sur les réponses éventuelles de l’IA.

Il disait aussi que pour faire de bons messages-guide, il faut parler à la machine comme on le fera à un employé junior, avec le plus de détails possible. Il faut aussi le corriger dès qu’il se trompe (ce qui peut quand même être fréquent) et le recadrer afin qu’il devienne l’outil idéal pour nous. Il suggère d’ailleurs de faire les étapes qui sont présentées ci-bas.

On peut aussi :

• Écrire des instructions claires

• Fournir des références

• Diviser une tâche complexe en plusieurs sous-tâches

• Donner au robot « le temps de penser », donc être un peu patient

• Utiliser des outils externes (comme d’autres robots, applications ou contenus)

• Et vérifier systématiquement les changements qui seront faits.

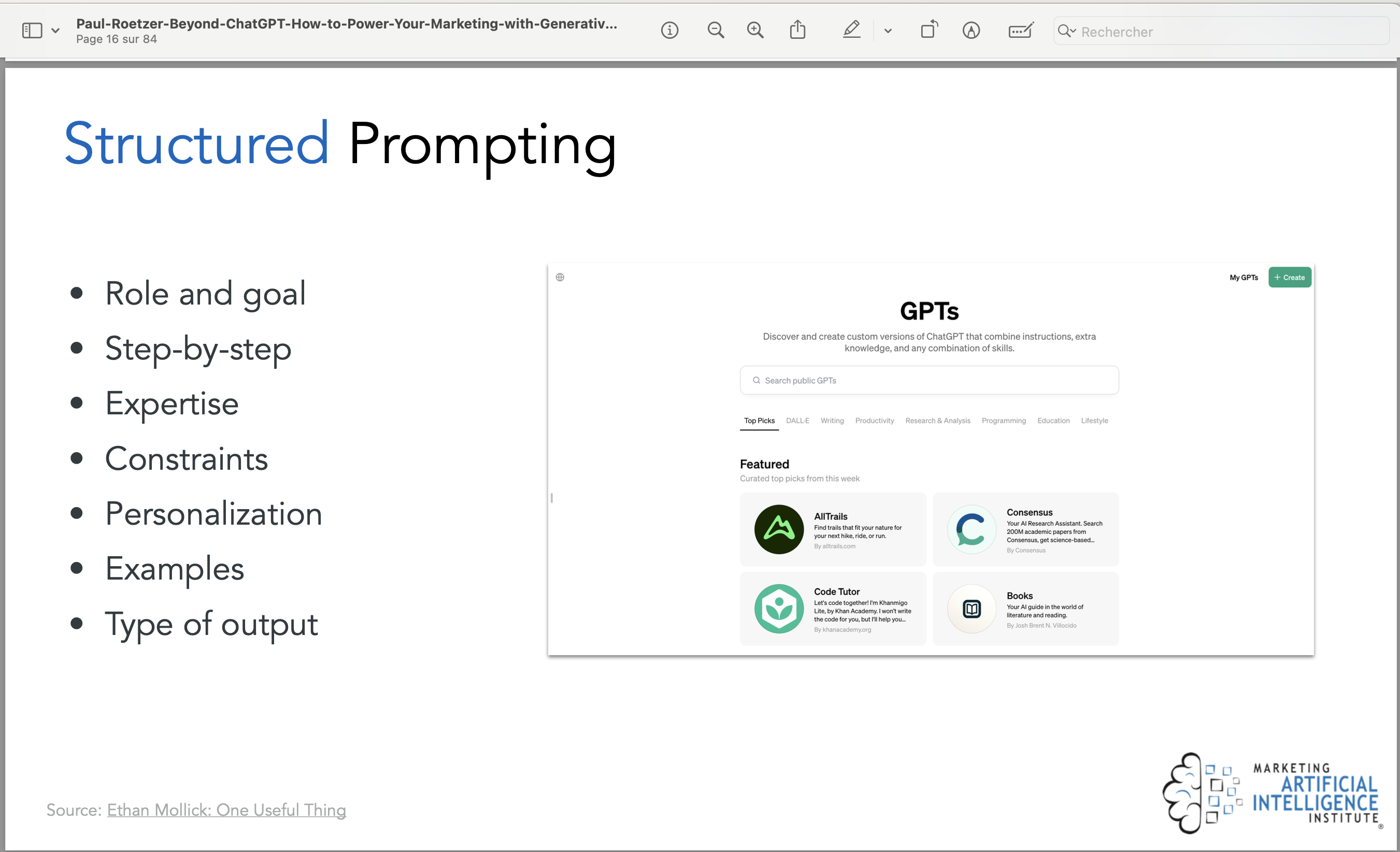

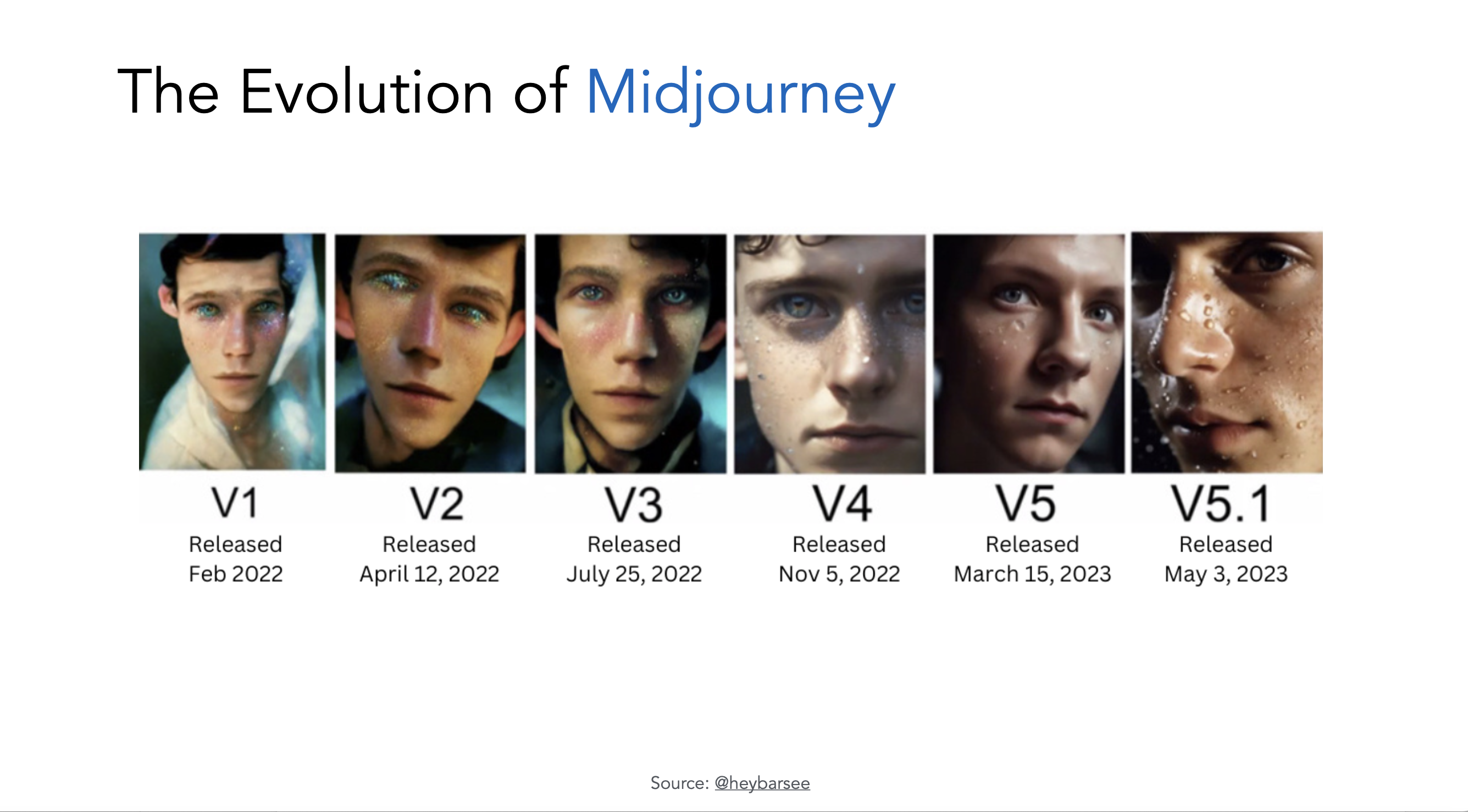

Il dévoilait aussi les différents politiques d’utilisations et limites qu’une organisation doit mettre en place afin de réguler convenablement l’IA, mais ce sera le sujet d’un prochain billet. Pour terminer cette démonstration plus qu’intéressante, il proposait ces deux prochaines diapositives qui présentent un portion de l’écosystème IA pertinente pour le marketing, de même que l’évolution spectaculaire de Midjourney en seulement 15 mois.

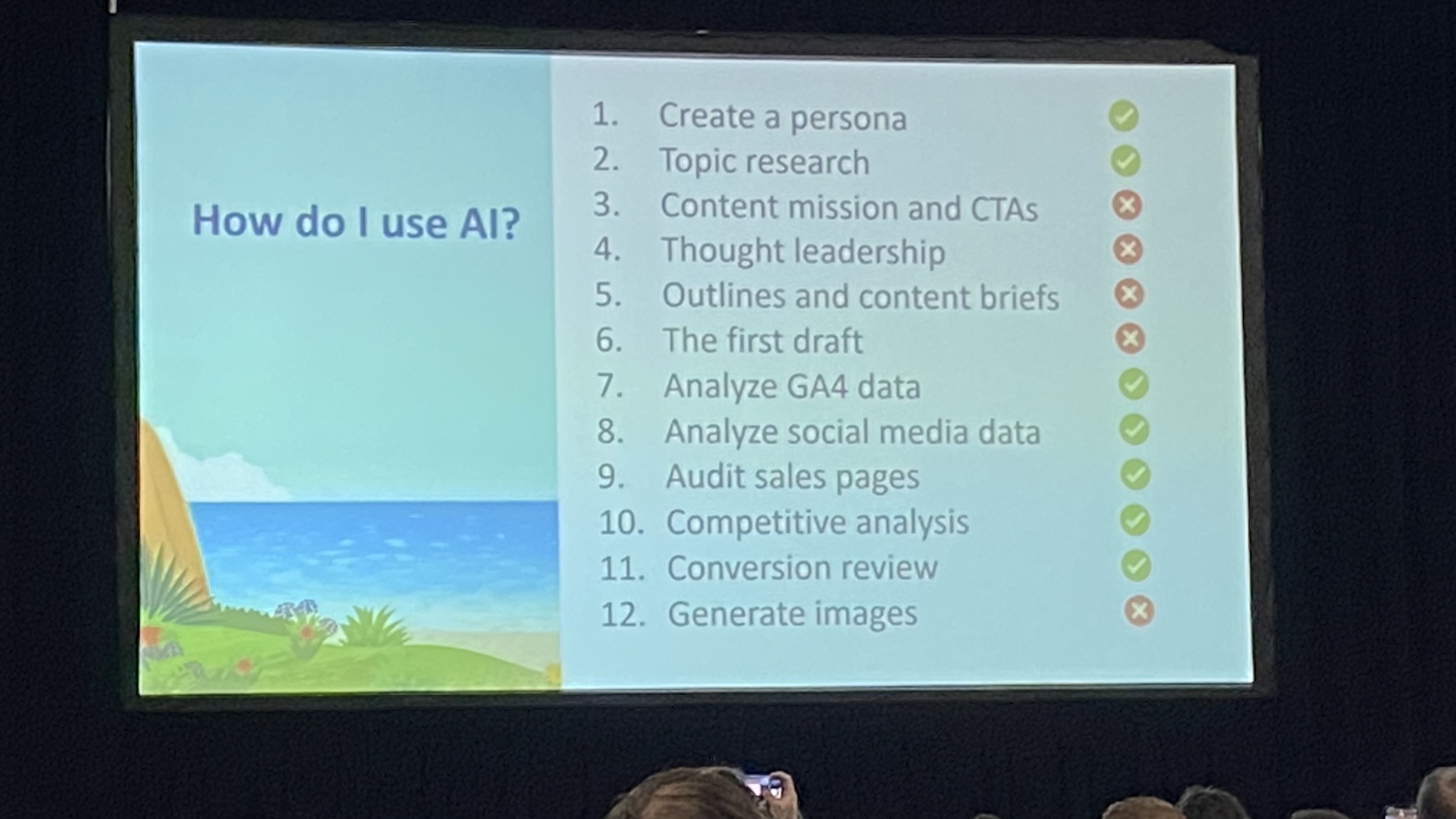

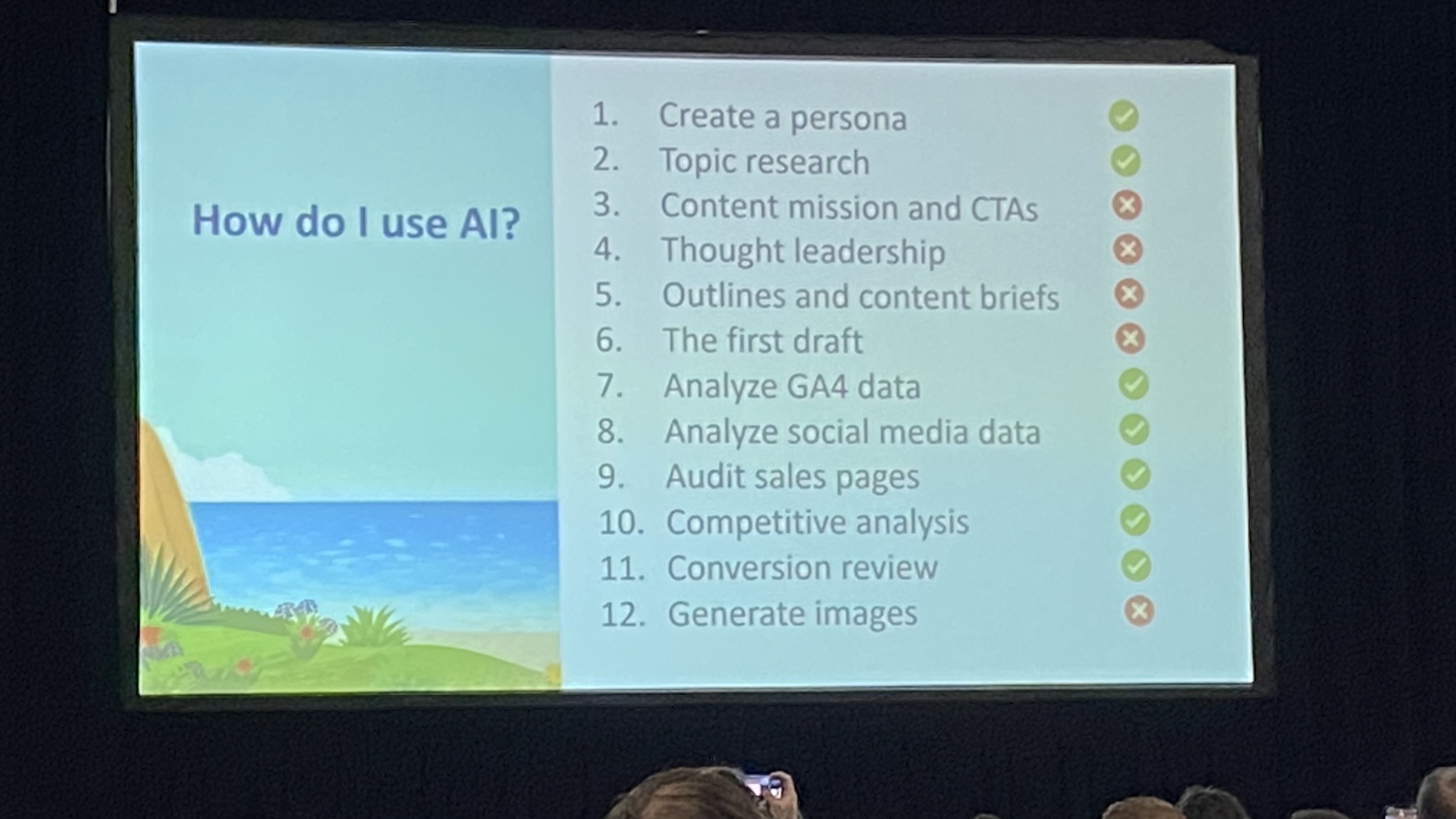

Un autre conférencier qui était plus que pertinent était Andy Crestodina. Il présentait certaines statistiques relatives à l’adoption de l’IA par les marketeurs, de même que les cas où il utilise l’Ia dans son travail de tous les jours. Notez ici qu’il ne l’utilise pas pour la création d’image. Comme je l’expliquais dans mon billet Revue de presse marketing/techno du 13 février au 28 février et mon entrevue à CHOI RadioX, il est évident que Gemini est loin d’être au point avec le récent scandale d’idéologie woke imbriqué dans le code, mais aussi parce que Dall-E de même que Leonardo.ia, semblent incapable de positionner un humain dans une voiture.

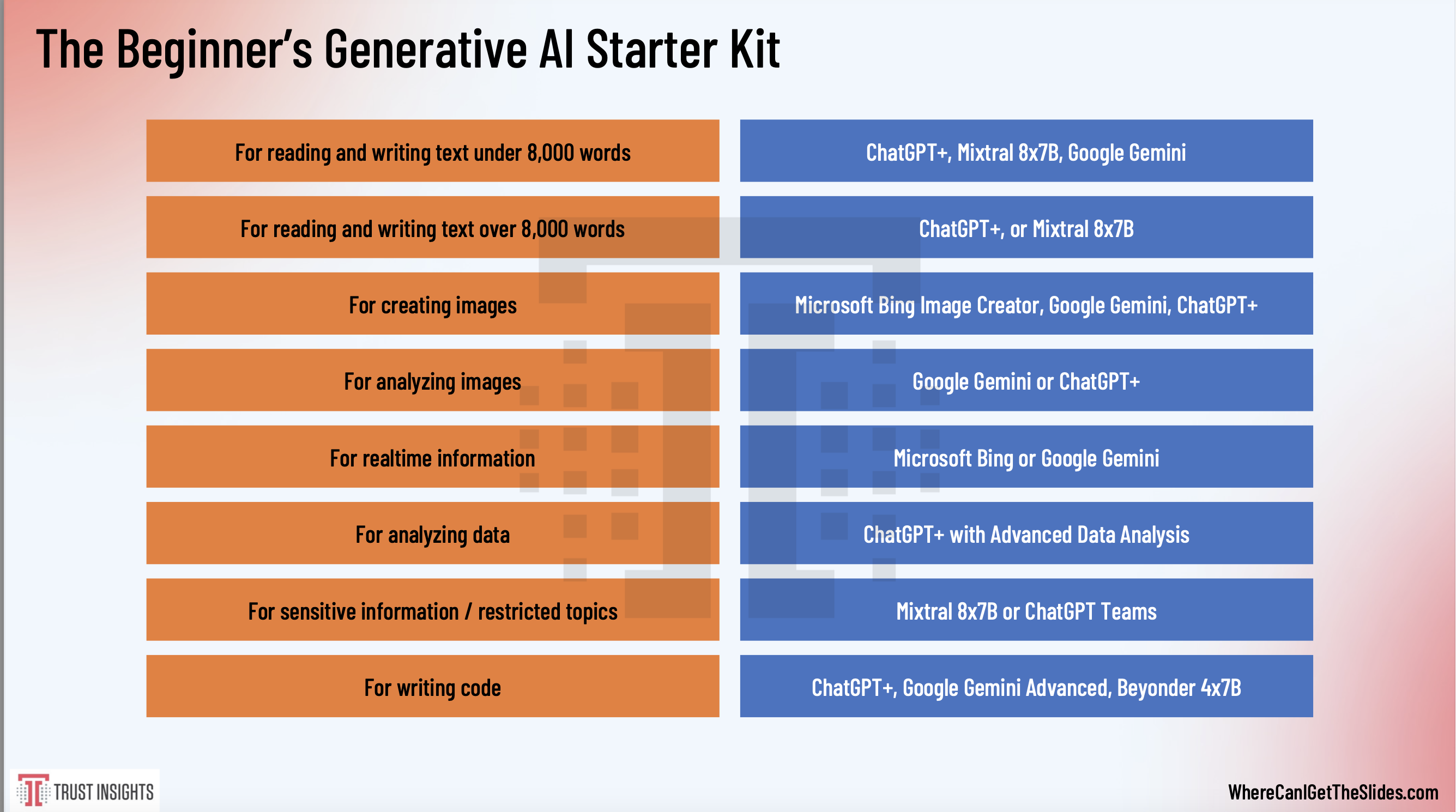

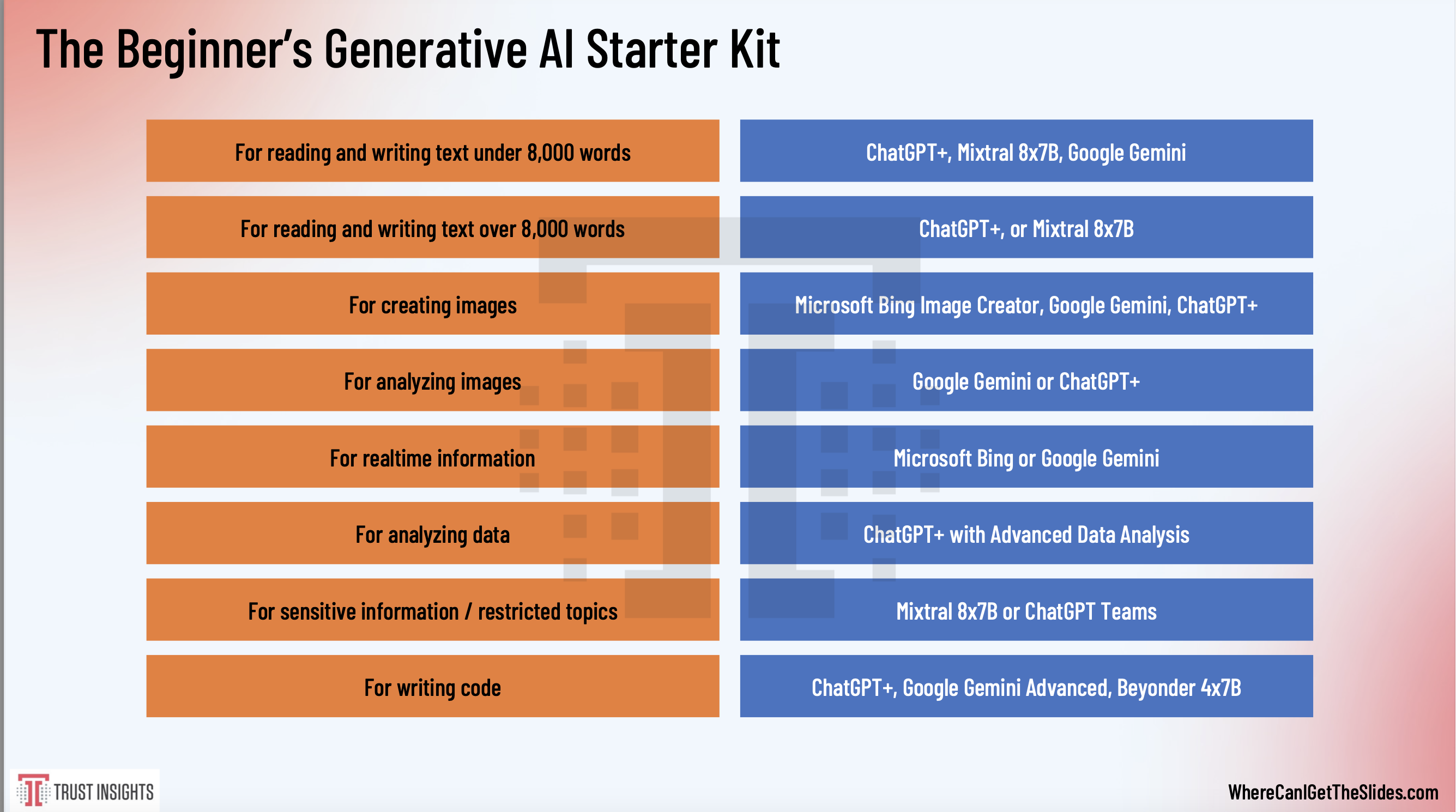

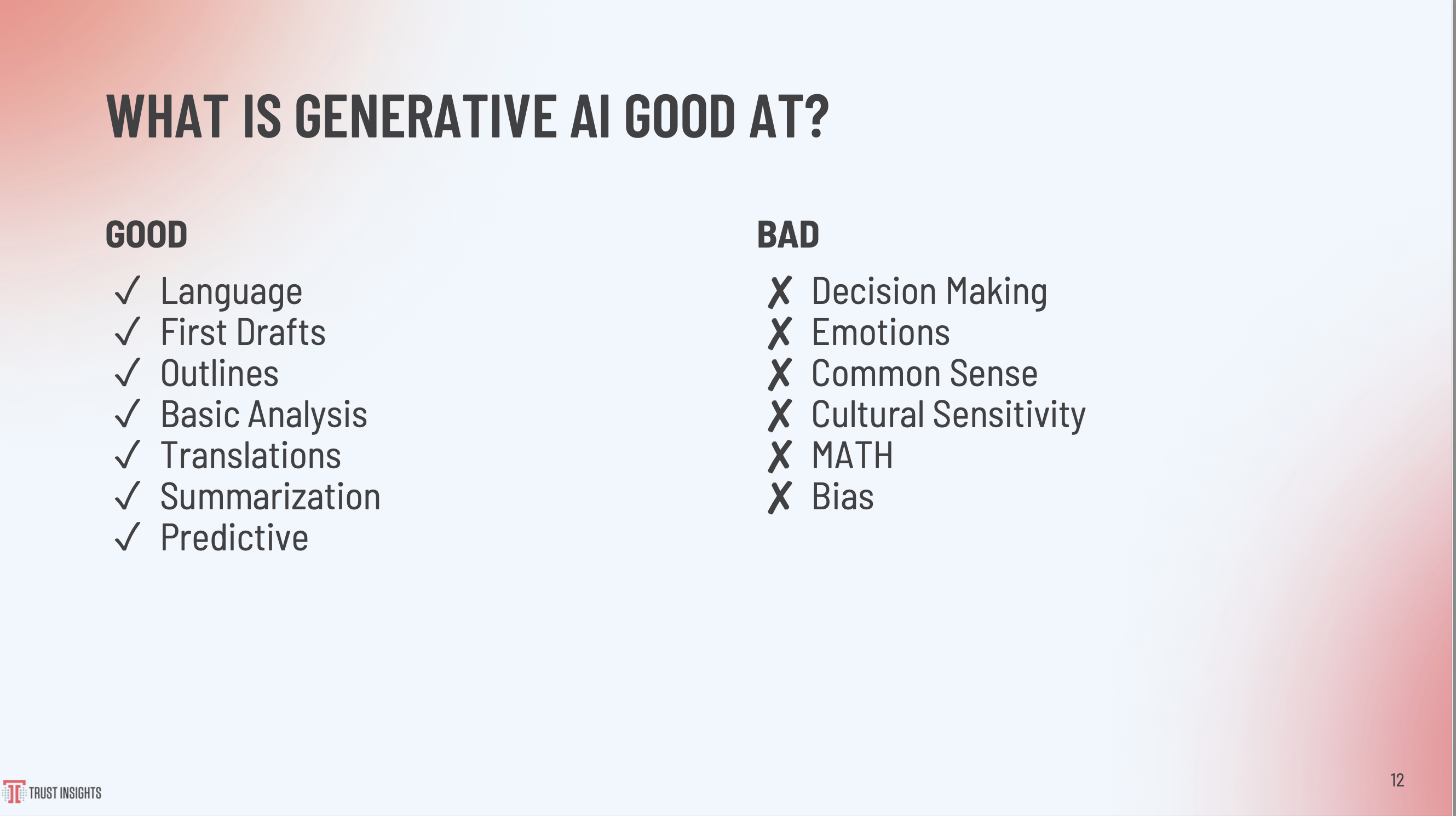

Enfin, la présidente de Trustinsight Katie Robbert, présente certaines diapos sur l’utilisation de l’IA à des fins marketing.

Tout ça pour vous dire qu’à partir de maintenant, je me plonge dans l’univers IA pour le marketing et qu’une nouvelle catégorie de ce blogue y sera consacrée.

Article publié le mercredi, 28 février 2024 sous les rubriques intelligence Artificielle, LLM, Marketing de contenu, Marketing Internet et Médias sociaux.

Vous pouvez suivre les commentaires sur cet article via ce fil RSS.

Vous pouvez laisser un commentaire ci-dessous ou un rétrolien à partir de votre site.

Libelés : Andy Crestodina, ChatGPT, Gémini, Katie Robbert, Paul Roetzer, SMMW24.